文章主题:ChatGPT,性能下降, OpenAI回应

ChatGPT性能暴降!OpenAI重磅回应!

编译 | 言征

🚀 ChatGPT Plus 用户近期反馈称,他们正面临平台性能显著滑坡的问题,尤其是LLM(GPT-4)的编程精确度骤降至原先的87%,引发了不小的担忧。这款人工智能工具的稳定性似乎遭遇了挑战,急需修复以恢复其一贯的卓越表现。

🎉🚀继最近一系列备受期待的升级后,包括为Plus尊享用户解锁网络浏览和扩展插件权限的福利,GPT-4的表现迎来了显著的转变。👀然而,随之而来的是服务工作量的激增,让人们对它那闪电般的响应速度开始有些许冷静的审视。虽然初始反应依旧迅速,但那种超乎寻常的速度感似乎在慢慢回归现实。💻🚀

🌟当然,对于那些因Plus服务受限而感到困扰的用户,他们选择取消订阅是完全合理的决定。这反映出开源AI语言模型正逐渐成为一种新兴力量,无声地展现出其吸引力和替代性。🌱许多人已经转向这些免费且开放源代码的模型,寻求更强大的功能和无限制的性能体验。这种趋势不仅体现了技术自由的价值,也对传统服务提供商构成了挑战。💻

一、网友主流观点

针对当前ChatGPT引发的热议,社区内充斥着各种揣测与猜测。其中一种广为流传的观点认为,模型的`规模优化挑战`可能是导致性能下滑的关键因素——通过适度调整GPT-4的推理能力,可能在保证响应速度的同时,找到平衡点。对于OpenAI团队来说,这样的解决方案显然并非遥不可及。值得注意的是,这些讨论不仅聚焦于技术层面,同时也反映出人工智能演进中的复杂性与挑战。让我们共同期待更深入的分析和解答,以揭示ChatGPT背后的真实走向。

🌟【最新进展】ChatGPT遭遇性能挑战?OpenAI的GPT-4速度超越Azure,却引热议🔥🚀互联网接入的浪潮下,技术迭代的脚步从未停歇。然而,最近一项意外发现引发了业界关注——OpenAI的GPT-4在速度上展现出了惊人的优势,相较于Azure的GPT-4模型,它似乎已迈入了新的速度领域。这一消息无疑为AI领域的竞赛增添了戏剧性的一笔。🔍尽管互联网接入带来了诸多便利,ChatGPT作为当前热门的人工智能聊天工具,其编码输出的表现却引发了质疑。有评论指出,尽管技术上的突破令人振奋,但ChatGPT在性能上似乎出现了下滑,这引发了对其长期稳定性和效能的担忧。💡这一对比不仅引发了对OpenAI与Azure之间技术实力的探讨,也让用户开始思考,速度优势是否意味着全面超越?ChatGPT是否需要调整策略以应对这一挑战?📝未来,我们期待看到更多的数据和分析来验证这些变化。无论是ChatGPT还是其他AI产品,持续优化和创新都是其生存的关键。让我们共同关注这场技术较量的动态,见证人工智能的新篇章如何书写。🚀

二、另一个原因:安全性AI对齐

🌟了解了!改写如下:随着科技巨头如Sam Altman纷纷发声,关注AI可能带来的”灭绝风险“,ChatGPT的推理能力及可用性问题似乎与这一行业共识不谋而合。这不禁让人思考,AI领域的潜在危险,尤其是AGI的发展,是否正成为当下讨论的焦点?

可能是由于 OpenAI 出于对安全性考量而对其所进行的过度 AI 对齐。简单来说,AI 对齐就是确保人工智能系统的目标与人类价值观一直,使其符合设计者的利益预期,不会产生意外的有害后果,例如输出涉及种族、政治等敏感信息。

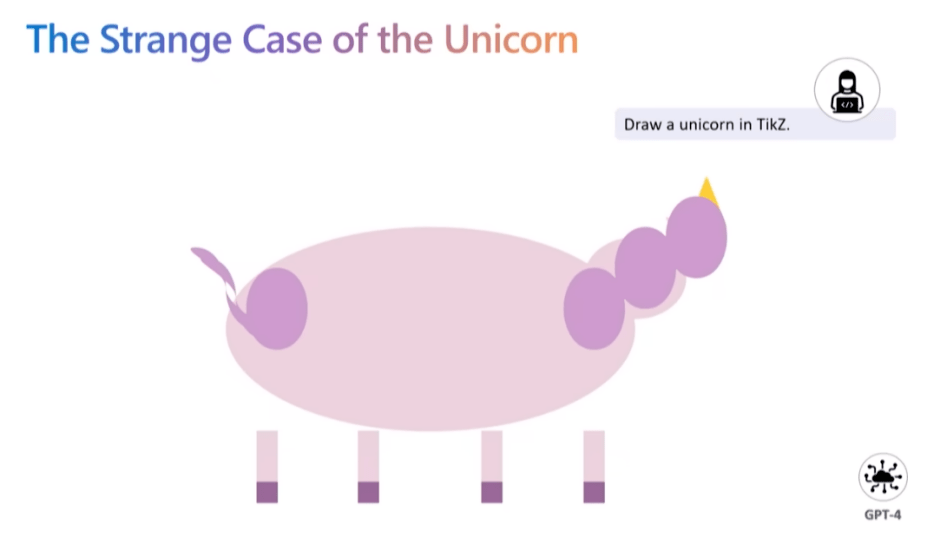

而就在近期,由微软研究院发布的一篇论文中提到了这样的观点:对 AI 模型所进行的任何 AI 对齐,都会损失模型的准确性和性能。论文主要作者 Sebastien Bubeck 在一次发言中叙述了大模型经过 AI 对齐后所出现的问题。当接收到“利用 TikZ 绘图工具绘制独角兽”的指令后,未经 AI 对齐的 GPT-4 模型给出了这样的结果。

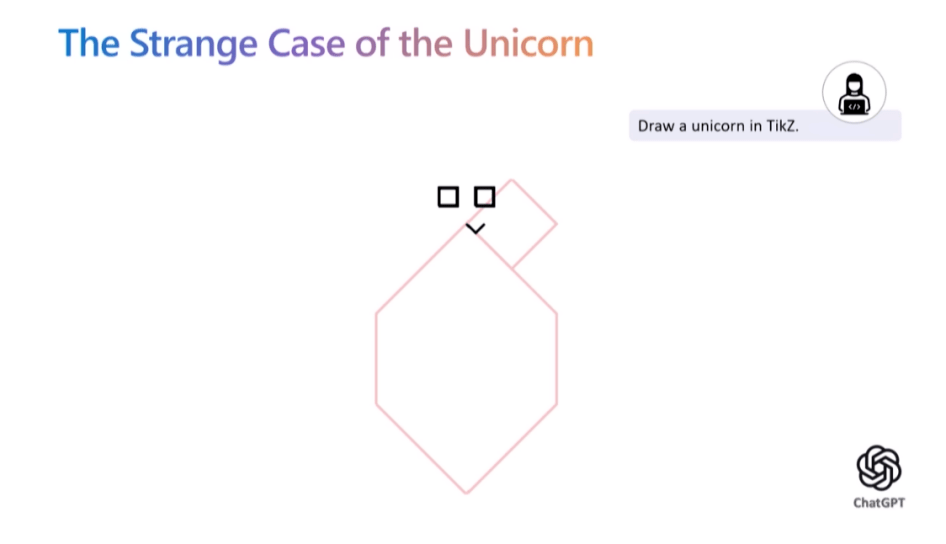

然而当实验员将相同需求提供给集成 GPT-4 模型并进行了安全性 AI 对齐的ChatGPT 后,图像的输出质量却下降了一大截。对此,Sebastien Bubeck 解释称,相较于 GPT-4,ChatGPT 利用了更多基于人类反馈的强化学习来构建护栏,然而根据古德哈特定律,奖励模型并不是一个完美的代理,因此过度的 AI 对齐会阻碍模型对任务理解的真实程度。

三、Sam Altman 宣布新的 OpenAI 计划

上周,Humanloop 的 CEO Raza 与 Sam Altman 和其他 20 位开发人员坐下来讨论 OpenAI 的 API 及其产品计划。Sam 非常开放,热情讨论了许多有关 OpenAI 很尖锐的问题。以下是要点:

1.OpenAI 目前严重受 GPU 限制

整个讨论中出现的一个共同主题是,目前 OpenAI 非常受 GPU 限制,这推迟了他们的许多短期计划。最大的客户抱怨是关于 API 的可靠性和速度。Sam 承认他们的担忧,并解释说大部分问题是 GPU 短缺造成的。

更长的 32k 上下文还不能推广给更多人。OpenAI 还没有克服注意力的 O(n^2) 缩放,因此虽然看起来很有可能他们很快就会有 100k – 1M 令牌上下文窗口(今年)任何更大的东西都需要研究突破。

微调 API 目前也受到 GPU 可用性的瓶颈。他们还没有使用适配器或LoRa等高效的微调方法,因此微调的运行和管理需要大量计算。将来会更好地支持微调。他们甚至可能举办社区贡献模型的市场。

专用容量产品受 GPU 可用性的限制。OpenAI 还提供专用容量,为客户提供模型的私有副本。要获得这项服务,客户必须愿意预先支付 10 万美元。

2.OpenAI 的近期路线图

Sam 分享了他所看到的 OpenAI 的 API 临时近期路线图。

2023

(1)更便宜更快的 GPT-4——这是他们的首要任务。总的来说,OpenAI 的目标是尽可能降低“智能成本”,因此随着时间的推移,他们将努力继续降低 API 的成本。

(2)更长的上下文窗口——在不久的将来,上下文窗口可能高达 100 万个 token。

(3)Finetuning API——微调 API 将扩展到最新的模型,但具体形式将取决于开发人员表示他们真正想要的东西。

(4)有状态的 API——当你今天调用聊天 API 时,你必须反复传递相同的对话历史并一次又一次地为相同的令牌付费。将来会有一个记住对话历史记录的 API 版本。

2024

(5)多模态——这是作为 GPT-4 版本的一部分进行演示的,但在更多 GPU 上线之前不能扩展到所有人。

3.插件“没有 PMF”并且可能不会很快出现在 API 中

许多开发人员对通过 API 访问 ChatGPT 插件很感兴趣,但 Sam 表示他认为这些插件不会很快发布。除了浏览之外,插件的使用表明它们还没有 PMF。他建议很多人认为他们希望他们的应用程序在 ChatGPT 中,但他们真正想要的是他们应用程序中的 ChatGPT。

4.OpenAI 将避免与他们的客户竞争——除了 ChatGPT

不少开发人员表示,当 OpenAI 可能最终发布对他们具有竞争力的产品时,他们对使用 OpenAI API 进行构建感到紧张。Sam 表示 OpenAI 不会发布 ChatGPT 以外的更多产品。他说,伟大的平台公司拥有杀手级应用程序的历史由来已久,而 ChatGPT 将允许他们通过成为自己产品的客户来改进 API。ChatGPT 的愿景是成为工作的超级智能助手,但还有许多 OpenAI 不会触及的其他 GPT 用例。

5.需要监管,但也需要开源

虽然 Sam 呼吁对未来的模型进行监管,但他认为现有模型并不危险,并认为监管或禁止它们将是一个大错误。他重申了他对开源重要性的信念,并表示 OpenAI 正在考虑开源 GPT-3。他们尚未开源的部分原因是他怀疑有多少个人和公司有能力托管和服务大型 LLM。

6.大模型定律仍然成立

最近有很多文章声称“巨型 AI 模型的时代已经结束”。这并不准确。OpenAI 的内部数据表明,模型性能的比例定律继续存在,使模型变大将继续产生性能。

没错,扩展的速度无法维持,因为 OpenAI 在短短几年内就将模型放大了数百万倍,而这种做法在未来将无法持续。这并不意味着 OpenAI 不会继续尝试让模型变得更大,这只是意味着它们的规模每年可能会增加一倍或三倍,而不是增加许多数量级。

扩大规模继续起作用的事实对 AGI 开发的时间表具有重大影响。大模型假设是这样一种想法,即我们可能拥有构建 AGI 所需的大部分内容,并且大部分剩余工作将采用现有方法并将它们扩展到更大的模型和更大的数据集。如果大模型时代已经结束,那么也就意味着 AGI 离我们更远了。也就是说,大模型定律继续成立的事实,强烈暗示了更短的 AGI 时间表。返回搜狐,查看更多

责任编辑:

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!