AI视频时代来临:AIGC创新引领文生图、文生音视频升级

文章主题:AIGC, 视频时代, 文生文, 文生图

来源:AI星球,文/王非

AIGC迈入视频时代!

在互联网内容逐步从图文向视频升级的过程中,我们正处在AIGC(人工智能生成内容)时代。在这个时代,文本、图像和音频视频的融合与创新正在迅速地推进。

在我国,我们有百度公司的CreateLab,它致力于利用人工智能技术创作高质量的视频内容。而在阿里巴巴集团旗下的达摩院,也有一项名为“文本生成视频大模型”的研究项目,该项目的目标是通过深度学习算法,将文本内容转化为生动的视频画面。在国外,谷歌公司也并非落后于他人,他们推出了名为Imagen的人工智能视频生成平台,以及由Meta领导的“做视频”(Make-A-Video)项目,这些技术都表明了全球范围内对于视频生成的技术研究正在飞速发展。

近期,备受瞩目的视频编辑工具 Runway 的 AI 技术得到了进一步的提升。由 Runway 开发的首个 AI 视频编辑工具 Gen 已从今年2月份的第一代产品升级至第二代,并已从内测阶段正式转向公众发布。

最重要的是,Gen-2可以免费试用。

Gen-2用户得分较Stable Diffusion 1.5高出73.53%,相较于Text2Live,这个数字更是高达88.24%。这些数据来自Runway的官方调研。

在Runway获得广泛好评的同时,其竞争对手Stability AI却陷入了“暴力拆解”的困境。根据福布斯杂志的报道,Stability AI被指责存在多项不当行为,其中包括“窃取”源代码、创始人的学历造假以及长期拖欠员工工资等问题。

Stability AI的创始人迅速做出了回应,他一一地回答了这些问题。然而,有些网友对此并不满意,他们认为他的回答并没有解决一些非常关键的问题。

一句话拍小电影!可免费体验105秒

Runway,这是一家于2018年成立的美国AI图片与视频编辑软件供应商,致力于为设计师、艺术家以及开发人员等各类用户提供丰富的工具和平台。通过引入先进的人工智能技术,Runway协助他们更好地创作出独具匠心的作品。

据传闻,斯蒂芬-科尔伯特主持的《深夜秀》制作团队运用了Runway软件对节目画面进行精细编辑;而电影《瞬息全宇宙》的视觉效果团队则更是充分利用了Runway公司先进的技术,精心构建了一系列引人入胜的场景。

今年2月,Runway发布了名为Gen-1的人工智能模型,可以通过应用文本提示或者参考图像所指定的任意风格,将现有视频转换为新视频。

网友使用Gen-1的效果是这样的:

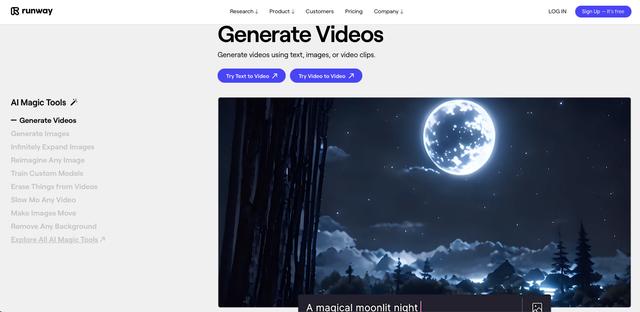

仅仅隔了一个多月,Runway于3月20日正式发布了更加强大的Gen-2,完成了从“编辑已有视频”,到“文生视频“的转变,并且提供文本+参考图像生视频、静态图片转视频、视频风格迁移等多个功能。

官方的宣传视频是这样的:

网友使用Gen-2的效果是这样的:

目前,可以在Runway网页端和其iOS版本上免费体验Gen-2。

Gen-2每次生成的视频限定为4秒钟,Runway提供有105秒的免费试用额度,用户最终可免费生成约26个视频。

如果想要继续使用Gen-2,用户需要购买会员,Runway还将提供去除水印、提升分辨率等功能。

定价方面,标准版会员15美元/月,Pro版会员35美元/月,年费会员可以打8折。

据报道,推特网友Steve Mills已经在Gen-2测试版中体验了它的潜在能力——生成MV。这名用户总共生成了大约500秒的视频,并最终剪辑成了140秒的MV。

该作者估计,如果按公开版的价格,整个制作下来至少要花费30美元。再加上之前的学习和摸索阶段,这个价格还会更高。

Runway CEO兼联合创始人Cristóbal Valenzuela在Gen-1发布时就曾表示:“我们曾见证过图像生成模型的大爆发,我坚信2023年会是属于视频生成模型的一年。”

正如Runway的Slogan,已经从“say it,see it”,转变为了:If you can imagine it ,you can generate it.

在用户登录界面,Runway则写道:“Everything you need to make anything you want”,你想要的(工具),我都有。

过去几年里,Runway从包括Felicis、Coatue、Amplify、Lux和Compound在内的顶级投资者那里筹集了资金。

就在本月初,有两名知情人士透露,谷歌对Runway进行了投资,包括这笔新资金在内,该公司的估值达到了15亿美元。

与Runway颇有渊源的竞对,刚刚遭福布斯“暴力拆解”

就在Runway一切顺风顺水发展的同时,与其颇有渊源,且同为AIGC独角兽的Stability AI,却是诸事不顺。

比如在融资层面,2022年10月,Stability AI完成了1.01亿美元融资,跻身独角兽行列。

随后,Stability AI创始人Emad Mostaque(伊玛德·莫斯塔克)一直在努力想要以大约40亿美元的估值再融资数亿美元,但是进展不顺。

就在近日,福布斯发布一则长新闻“暴力拆解”Stability AI,通过30多位前员工+投资人现身说法,细数该公司及其创始人伊玛德的九大罪证。

除了融资困难遭投资人怀疑,还包括:“窃取”源代码、拖欠工资且不交税、创始人学历造假、创始人工作经历造假、夸大公司收入、夸大与亚马逊的合作、碰瓷世卫组织及世界银行等机构、涉及版权官司。

针对福布斯罗列的九大罪状,伊玛德火速进行了相关回应,但是部分网友仍不认可,直言他并未完全澄清。

下面,以“窃取”源代码为例,看看福布斯笔下Stability AI的真实模样:

Stability AI曾因推出AI图像生成器Stable Diffusion,获得广泛关注。

据悉,这一模型的核心代码是由慕尼黑大学、海德堡大学和Runway的一组研究人员共同完成,最初被命名为Latent Diffusion,仅使用了几十个英伟达GPU进行了相关训练。

2022年6月,伊玛德提出向这群学者提供Stability的超级计算机,给他们训练模型。仅仅两个月后,被改进后的新模型Stable Diffusion正式推出。

在Stability AI发布的新闻稿中,将伊玛德称为“有史以来最受欢迎的开源软件”的首席布道者。随后,该公司还在筹款平台中表示,“Stability AI是Stable Diffusion背后的公司”、“它是我们的模型”,根本没有提到Runway等作者。

领导这一研究的教授Björn Ommer表示,本来他是希望借此可以宣传他实验室所做的工作,只是在Stable Diffusion对外发布时,他所在大学的整个新闻部门都在休假。

针对这一质疑,伊玛德认为“其实不需要做过多的解释”,因为公司已经多次公开声明,Stability AI与慕尼黑大学、Runway的计算机和视觉学习小组一起开发了Stable Diffusion的第一个版本。自Stable Diffusion发布以来,这一合作的细节一直在CompVis下的GitHub和Stability AI的网站上公开分享。

不过,Stability AI的声明中似乎忽略了海德堡大学。

此外,Latent Diffusion&Stable Diffusion的五位作者中,有三位现在在Stability AI工作,其中两位是共同第一作者。

值得一提的是,Runway在2022年的10月份,紧随其后发布了新版本的Stable Diffusion。

得悉此事的Stability AI声称Runway窃取了自己的知识产权,而这也引发后者创始人Cristóbal Valenzuela回怼:“这项技术是开源的,根本不存在侵犯版权的可能。”

随后,伊玛德撤回了指控,并对福布斯编辑解释道,自己其实是担心Runway的模型版本缺乏护栏。

目前,Björn Ommer的实验室和Runway都停止了与Stability AI的合作。

此外,伊玛德在去年的投资者介绍中,更是将Midjourney描述为Stability AI“生态系统”的一部分:“共同创造”了该产品并“组织”了其用户社区。

但Midjourney创始人告诉福布斯,伊玛德只是提供了“非常小”的一部分财务捐赠,除此之外与Midjourney没有任何关系。

两家昔日竞对,发展到如今局面,确实令人唏嘘,后续我们也将密切关注两家的最新进展。

AIGC, 视频时代, 文生文, 文生图

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!