文 | 周鑫雨

编辑 | 苏建勋

在大模型“扎堆”发布的当下,市场亟需更直观的方式,对模型能力做出判断。

🎉【最新动态】🚀 2023年3月16日,百度文心一言发布会揭秘!💡 模型演示方式引人关注,创新采用录播Demo,引领行业新风尚。🔍 百度CEO李彦宏的深度解析,为技术进步提供了独特视角。在这场盛大的活动中,百度展示了其在人工智能领域的卓越实力,而录播Demo的独特呈现方式不仅打破了传统,也为用户带来了更为直观、便捷的学习体验。🌟关于这一决策背后的原因,据透露,百度CEO李彦宏强调了技术的实用性与用户体验的重要性,旨在通过这种方式更好地服务于广大用户,提升产品亲和力。👩💻对于想要深入了解百度文心一言的读者朋友们,这无疑是一个不容错过的机会,赶快关注,紧跟科技步伐!🌐SEO优化提示:#百度文心# #录播Demo# #人工智能# #用户体验# #技术进步

🌟【AI变数揭秘】🔥每次生成式AI的回答都如变奏曲,引人深思,却也带来了不确定性的挑战。🔍然而,真正让我信服的是,全球所有此类发布会无一例外,均以录制而非现场演示呈现。👀这种一致性,暗示了背后的技术实力与独特性。もし皆可,则我们亦能从容应对。💪原内容:“我们的产品经过严格测试,可以确保100%的准确率。”🌟【品质保证】🎯我们的承诺,基于严谨的测试。每一步都精雕细琢,只为确保100%的准确性,为你提供无懈可击的结果。🛠️

🎉【技术盛宴】🔥 5月9日,百度引领潮流,打破沉寂!🌟 在近一个月后的盛会上,他们以创新的姿态,展示了令人震撼的“文心千帆大模型平台”实力。💥 这不仅仅是技术的进步,更是对未来智能文字领域的深度探索和突破。🔍🎉 惊艳全场!🔥 百度不再保守,以实际行动诠释了其在人工智能领域的决心与雄心。🌟 他们用实操演示,让参会者一窥这个强大平台的无限可能,为内容创作开启全新篇章。✍️💡 SEO优化提示:提及“文心千帆大模型”、“智能文字领域”和“创新突破”,提升搜索引擎可见度。

🌟🚀百度于2023年3月27日震撼发布【文心千帆】全能型大模型平台!🎉🔍集成了【文心一言】的强大功能,提供一站式的【调用+训练+优化】服务💡💪私有化部署选项丰富,无论是公有云的【推理微托管】,还是私有的【软件授权+软硬一体租赁】,都能满足您的定制需求🔥🚀不论是云端使用还是本地部署,文心千帆都将引领智能文字的新高度!🏆🌐

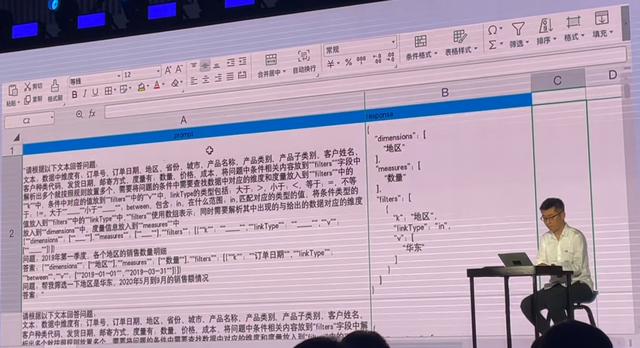

此次现场演示,百度主要展现了文心千帆的推理能力调用和模型微调两部分。

文心一言Sugar现场生成了销售额的饼图。

📊📊数据可视化神器展示实力!使用Sugar,文心一言轻松驾驭结构化数据,一键生成饼图,操作流畅,效果显著。但对于复杂的图表需求,比如绘制折线图,百度工程师的智慧不容小觑。他们巧妙利用文心千帆的大模型平台,通过微调和100条标注数据的精准输入,对Prompt进行了实时调整,实现了这一高级功能。🚀🎉技术的力量,让数据讲述的故事更加丰富多彩!

文心千帆支持模型微调。

🌟【技术革新】🚀 文心千帆展现强大能力:仅100条标注,微调与定制化高效完成!🔍百度智能云AI&B大平台总经理忻舟揭秘:创新平台文心千帆,以图形化界面引领变革。🎯 不再需要深陷代码海洋或繁琐的命令行操作,用户只需聚焦核心业务数据和应用。💡简单几步,就能在文心千帆上进行深度训练与优化,无需专业知识,轻松驾驭大模型。🚀 无论是模型定制还是推理应用,它都以直观易用的方式,为业务加速提供强大支持。🏆让技术更贴近业务,让创新触手可及!🌍# 文心千帆 # AI微调 # 数据驱动 # 商业应用

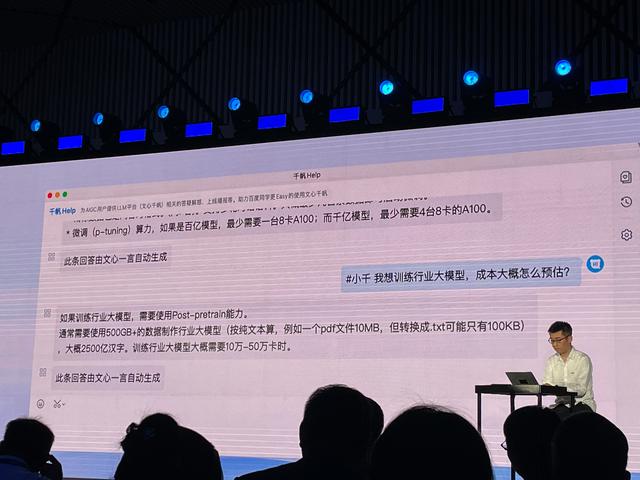

与此同时,AI时代的“向内革命”也正在百度内部悄然发生,百度搜索、推荐、地图、如流、小度等产品已经接入了文心一言。

百度内部办公软件“如流”上线了AI小助手。关于行业大模型训练成本,小助手给出的回答是“10万-50万卡时”。

百度集团副总裁侯震宇表示,对客户而言,成本和模型性能才是评价大模型的两项指标。

“训练一个大模型,动辄三个月,一两千万美元,假如每一个企业都需要付出这么高的代价,门槛那么高,显然百度也不会进入这个市场。”他表示,即便从头训练模型的成本依然高昂,但是使用大模型、以及基于大模型底座训练和微调模型的成本已经有显著的降低,“现在调用文心一言的成本,已经降低到模型刚发布时(3月16日)的10%”。

近日谷歌内部流出的一份文件表示,未来OpenAI和谷歌等厂商开发的闭源大模型将不可避免地受到开源模型的冲击。有其随着Meta自研的大模型LLaMa泄露,围绕这一基座的开源模型生态正在迅猛地发展。文件还提到,企业可以免费使用开源模型,并且更加灵活可控。“我们没有壁垒,OpenAI也没有”。

“大家觉得大模型成本非常高,是因为大模型算力成本高,其次是大模型数据成本。开源模型也绕不开大量的GPU,所以并不是开源成本一定低。”侯震宇则向36氪给出了相反的答案。

他认为,免费开源模型的调用成本并不意味着更低:“一方面,一般企业不见得能够用得起两三千张集群卡,另一方面是不一定能够用好,在这么大的集群量中如果出现了BUG很难调整,需要有整体的调优服务能力。大模型贵是因为量大且训练时间长,在成本这方面,最终要看是否有整体端到端的成本控制能力,这样一定会比纯粹去买成本要低。”

随着大模型的落地逐渐从“摸石过河”走向实践的“中场战事”,低成本和高性能将是不同大模型厂商不断演练的课题。

36kr制图