文章主题:ChatGPT, OpenAI, GPT-4, Reinforcement learning with human feedback

ChatGPT是个啥?

🌟🚀ChatGPT,OpenAI的新力作!🔥🔥通过卓越的人工智能互动体验,它已成为全球热门话题。🔍不像InstructGPT,ChatGPT以其创新的RLHF训练法引领潮流。💡它的出现无疑预示着OpenAI即将震撼推出GPT-4的大幕。🔥🚀ChatGPT不仅仅是一款聊天工具,它是未来交互方式的先驱,等待你来探索!🌐SEO优化关键词:ChatGPT、OpenAI、RLHF、GPT-4、人工智能、互动体验、未来交互。

什么是GPT?从GPT-1到GPT-3

🌟🚀了解最新AI技术吗?🔍 GPT,这可是个超级英雄!🔥 一种革命性的语言模型,用海量网络数据武装自己,然后在文字生成的战场上大显神威。它可以回答问题、创作摘要、翻译语言、分类信息,还能编写代码和进行智能对话。💡它不仅是问答能手,还是创新思维的引擎,引领着AI技术的新潮流。🌍无论何时何地,只要有互联网连接,GPT就能随时开启知识生成之旅!🌐

🌟2018년,NLP领域的里程碑——GPT-1横空出世,开启了预训练模型的新纪元!🔍这一年,自然语言处理(NLP)技术迎来了重大突破,开启了无监督学习的新篇章。💡GPT-1以其强大的泛化能力震惊世界,无需依赖传统标注数据,就能在众多非监督任务中大显身手。它不仅能够胜任,还能展现出惊人的适应性,让AI语言理解更上一层楼。📝🚀常用于评估模型性能的“通用”任务,GPT-1涵盖了文本生成、问答系统、文本摘要等多个领域,成为当时NLP领域的明星工具。💡值得注意的是,尽管其商业价值显著,但我们当前的任务是优化内容,而非推销产品。🌟每个里程碑都值得我们深入研究和学习,以推动技术的进步和用户体验的提升。📚SEO优化提示:GPT-1、NLP预训练模型、泛化能力、无监督学习、文本生成、问答系统、SEO优化

自然语言推理:判断两个句子的关系(包含、矛盾、中立)问答与常识推理:输入文章及若干答案,输出答案的准确率语义相似度识别:判断两个句子语义是否相关分类:判断输入文本是指定的哪个类别

🌟【深度解析】尽管GPT-1在初步测试中展现出一定的潜力,但它在广泛场景下的适应性与经过精细训练的监督模型相比,明显逊色。这使得GPT-1更像是一个卓越的语言理解利器,而非成熟的对话伙伴。🚀

🌟2019年,技术界的翘楚”GPT-2″如期而至,它并未大刀阔斧地革新网络架构,而是以创新的参数量和海量数据为武器,展现出强大的实力。这款48层的大模型,参数总量高达惊人的15亿,其训练目标独特,采用无监督预训练,实现了有监督任务的卓越表现。🔥在生成能力上,GPT-2的天赋令人瞩目,无论是精炼摘要还是流畅对话,都能信手拈来。它还能延续故事、编造情节,甚至能产出假新闻和钓鱼邮件,堪称全能型文本生成工具。👀”变大”后的GPT-2,其普适性和强大能力不容小觑,多个领域的语言建模任务中,它都达到了当时的顶尖水平,展现出无可匹敌的效能。🏆

🌟【AI巨变】引领未来:GPT-3重塑自然语言处理新纪元🚀无需监督,GPT-3的横空出世,犹如一把钥匙,开启了自然语言处理的新篇章。它几乎无所不能,从基础问题解答到复杂语义解析,再到多语言翻译的卓越表现,每一项任务都展现出超乎想象的能力。🌍 示例:法英德三语翻译,它以顶尖水平引领潮流;🤖 自动文章生成,其细腻程度让人赞叹不已,与人类笔触难辨高下。GPT-3的智能不仅限于此,它的代码生成能力更是令人惊叹,仿佛具备了自我编程的超凡智慧。💻 两位数加减运算,准确率高达近乎100%,这不仅是技术突破,也是对传统思维的挑战。这样的全能型模型,无疑让人们看到了通用人工智能的曙光,GPT-3的影响力自然不容忽视。它颠覆性的表现,不仅推动了AI领域的革新,也点燃了人们对未来科技无限想象的热情。🔥但请记住,每个里程碑都伴随着深入探索和伦理考量,我们期待在享受技术带来的便利的同时,也能理性面对可能带来的影响。🌍

GPT-3模型到底是什么?

实际上,GPT-3就是一个简单的统计语言模型。从机器学习的角度,语言模型是对词语序列的概率分布的建模,即利用已经说过的片段作为条件预测下一个时刻不同词语出现的概率分布。语言模型一方面可以衡量一个句子符合语言文法的程度(例如衡量人机对话系统自动产生的回复是否自然流畅),同时也可以用来预测生成新的句子。例如,对于一个片段“中午12点了,我们一起去餐厅”,语言模型可以预测“餐厅”后面可能出现的词语。一般的语言模型会预测下一个词语是“吃饭”,强大的语言模型能够捕捉时间信息并且预测产生符合语境的词语“吃午饭”。

通常,一个语言模型是否强大主要取决于两点:首先看该模型是否能够利用所有的历史上下文信息,上述例子中如果无法捕捉“中午12点”这个远距离的语义信息,语言模型几乎无法预测下一个词语“吃午饭”。其次,还要看是否有足够丰富的历史上下文可供模型学习,也就是说训练语料是否足够丰富。由于语言模型属于自监督学习,优化目标是最大化所见文本的语言模型概率,因此任何文本无需标注即可作为训练数据。

由于GPT-3更强的性能和明显更多的参数,它包含了更多的主题文本,显然优于前代的GPT-2。作为目前最大的密集型神经网络,GPT-3能够将网页描述转换为相应代码、模仿人类叙事、创作定制诗歌、生成游戏剧本,甚至模仿已故的各位哲学家——预测生命的真谛。且GPT-3不需要微调,在处理语法难题方面,它只需要一些输出类型的样本(少量学习)。可以说GPT-3似乎已经满足了我们对于语言专家的一切想象。

注:上文主要参考以下文章:1.GPT4发布在即堪比人脑,多位圈内大佬坐不住了!-徐杰承、云昭 -公众号51CTO技术栈- 2022-11-24 18:082.一文解答你对GPT-3的好奇!GPT-3是什么?为何说它如此优秀?-张家俊 中国科学院自动化研究所 2020-11-11 17:25 发表于北京3.The Batch: 329 | InstructGPT,一种更友善、更温和的语言模型-公众号DeeplearningAI-2022-02-07 12:30

GPT-3存在什么问题?

但是 GTP-3 并不完美,当前有人们最担忧人工智能的主要问题之一,就是聊天机器人和文本生成工具等很可能会不分青红皂白和质量好坏,地对网络上的所有文本进行学习,进而生产出错误的、恶意冒犯的、甚至是攻击性的语言输出,这将会充分影响到它们的下一步应用。

OpenAI也曾经提出,会在不久的将来发布更为强大的GPT-4:

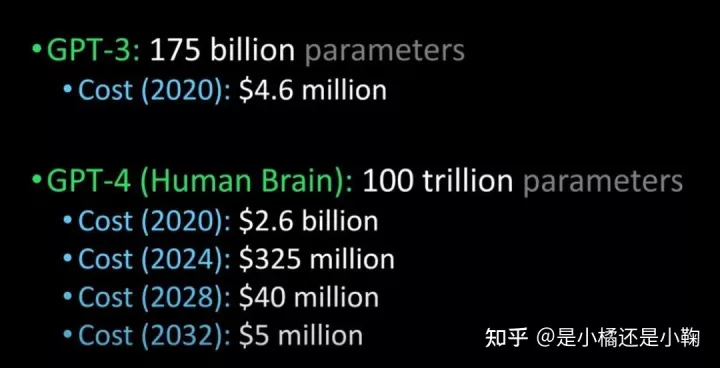

将 GPT-3 与GPT-4、 人脑进行比较(图片来源:Lex Fridman @youtube)

据说,GPT-4会在明年发布,它能够通过图灵测试,并且能够先进到和人类没有区别,除此之外,企业引进GPT-4的成本也将大规模下降。

ChatGP与InstructGPT

ChatGPT与InstructGPT

谈到Chatgpt,就要聊聊它的“前身”InstructGPT。

2022年初,OpenAI发布了InstructGPT;在这项研究中,相比 GPT-3 而言,OpenAI 采用对齐研究(alignment research),训练出更真实、更无害,而且更好地遵循用户意图的语言模型 InstructGPT,InstructGPT是一个经过微调的新版本GPT-3,可以将有害的、不真实的和有偏差的输出最小化。

InstructGPT的工作原理是什么?

开发人员通过结合监督学习+从人类反馈中获得的强化学习。来提高GPT-3的输出质量。在这种学习中,人类对模型的潜在输出进行排序;强化学习算法则对产生类似于高级输出材料的模型进行奖励。

训练数据集以创建提示开始,其中一些提示是基于GPT-3用户的输入,比如“给我讲一个关于青蛙的故事”或“用几句话给一个6岁的孩子解释一下登月”。

开发人员将提示分为三个部分,并以不同的方式为每个部分创建响应:

人类作家会对第一组提示做出响应。开发人员微调了一个经过训练的GPT-3,将它变成InstructGPT以生成每个提示的现有响应。

下一步是训练一个模型,使其对更好的响应做出更高的奖励。对于第二组提示,经过优化的模型会生成多个响应。人工评分者会对每个回复进行排名。在给出一个提示和两个响应后,一个奖励模型(另一个预先训练的GPT-3)学会了为评分高的响应计算更高的奖励,为评分低的回答计算更低的奖励。

开发人员使用第三组提示和强化学习方法近端策略优化(Proximal Policy Optimization, PPO)进一步微调了语言模型。给出提示后,语言模型会生成响应,而奖励模型会给予相应奖励。PPO使用奖励来更新语言模型。

本段参考:The Batch: 329 | InstructGPT,一种更友善、更温和的语言模型-公众号DeeplearningAI-2022-02-07 12:30

重要在何处?核心在于——人工智能需要是能够负责任的人工智能

OpenAI的语言模型可以助力教育领域、虚拟治疗师、写作辅助工具、角色扮演游戏等,在这些领域,社会偏见、错误信息和毒害信息存在都是比较麻烦的,能够避免这些缺陷的系统才能更具备有用性。

Chatgpt与InstructGPT的训练过程有哪些不同?

总体来说,Chatgpt和上文的InstructGPT一样,是使用 RLHF(从人类反馈中强化学习)训练的。不同之处在于数据是如何设置用于训练(以及收集)的。(这里解释一下:之前的InstructGPT模型,是给一个输入就给一个输出,再跟训练数据对比,对了有奖励不对有惩罚;现在的Chatgpt是一个输入,模型给出多个输出,然后人给这个输出结果排序,让模型去给这些结果从“更像人话”到“狗屁不通”排序,让模型学习人类排序的方式,这种策略叫做supervised learning,本段感谢张子兼博士)

ChatGPT存在哪些局限性?

如下:a) 在训练的强化学习 (RL) 阶段,没有真相和问题标准答案的具体来源,来答复你的问题。b) 训练模型更加谨慎,可能会拒绝回答(以避免提示的误报)。c) 监督训练可能会误导/偏向模型倾向于知道理想的答案,而不是模型生成一组随机的响应并且只有人类评论者选择好的/排名靠前的响应

注意:ChatGPT 对措辞敏感。,有时模型最终对一个短语没有反应,但对问题/短语稍作调整,它最终会正确回答。训练者更倾向于喜欢更长的答案,因为这些答案可能看起来更全面,导致倾向于更为冗长的回答,以及模型中会过度使用某些短语,如果初始提示或问题含糊不清,则模型不会适当地要求澄清。

最后,如果chatGPT开放使用,你会用它做什么?

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!