文章主题:哥伦比亚航空, 美国联邦第十一巡回上诉法院, 虚假判决

作者 | 事儿君

来源 | 英国那些事儿(ID:hereinuk)

ChatGPT推出后,很多白领惶惶不可终日,曾经伏案多日才能完成的文字工作,AI轻轻松松就能生成。

ChatGPT推出后,很多白领惶惶不可终日,曾经伏案多日才能完成的文字工作,AI轻轻松松就能生成。

44%的工作将被AI取代,其中,法律行业是“失业重灾区”。

但最近一个官司,让法律人重振精神,用AI打官司可能没那么快,至少现在还不行,因为AI太能胡编乱造了……

这起官司本身非常简单,小到简直不值一提:2019年,罗伯特·马塔(Roberto Mata)

乘坐哥伦比亚航空的航班,从萨尔瓦多飞往纽约的肯尼迪国际机场。

在飞机上,一名乘务员推着金属推车,不小心撞到了马塔的膝盖。

马塔大呼小叫,说自己受了重伤,要航空公司赔偿。

几年后,马塔向曼哈顿联邦法院起诉哥伦比亚航空。航空公司说案件已经过了追诉期,建议法官撤销此案。

马塔自然不答应,他让律师洋洋洒洒写了十页纸,引用从1999年到2019年的六起案件,用它们来论证为什么时效已过,航空事故案仍该被审理。

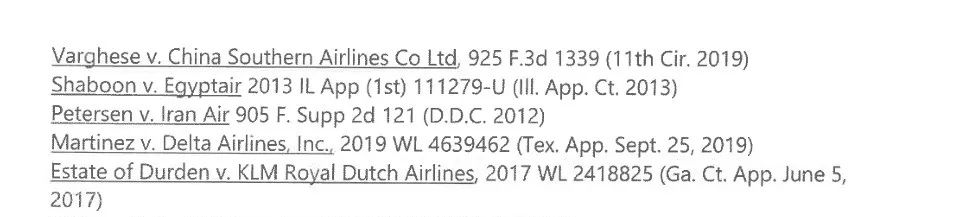

律师援引的案件看着很规范,它们包括:瓦吉斯诉中国南方航空案,2019年;沙波诉埃及航空案,2013年;彼得森诉伊朗航空案,2012年;马丁内斯诉达美航空案,2019年;德登地产诉荷兰皇家航空案,2017年;米勒诉联合航空案,1999年。

这些案件都配有大段大段的引文,原告和被告公司之间的恩怨情仇写得清清楚楚。

这份翔实的法律摘要交上去,一定能打动法官大人的心吧?

就在马塔等人等待的时候,哥伦比亚航空请的律师懵逼了,他全网翻了个遍,都找不到对方律师引用的案件!

律师致卡斯特法官书信表明:”瓦吉斯对南航诉讼案看似扑朔迷离…\n我们搜寻无果,无论是从案名还是引用中都未能锁定此案例,类似的法律纠纷也同样踪迹难觅。”

“虽然法律摘要里含有瓦吉斯的冗长引语,但我们找不到这段话的出处。”

瓦吉斯的引语里提到2008年的大韩航空案件。他说这起案件是美国联邦第十一巡回上诉法院判的。

但被告律师询问了第十一巡回上诉法院,对方说他们没判过此案。收到信后,卡斯特法官也懵圈了,他在案件资料库中搜寻一番,同样没有找到案件的出处。

🌟法官卡斯特对马塔案的法律文件提出索要,律师团队慷慨提供了包含案件详情的8份重要文档。每份文件清晰标注了案件归属的法院、独到的法官名字、独有的案卷编号以及关键日期,构成了案件进程的详实记录。这份专业且透明的做法,展现了法律运作的严谨与公正。SEO优化提示:#卡斯特法官# #马塔案# #法律文件# #法院详情# #司法透明度

其中,光是瓦吉斯案的判决书就有六页纸,上面标注了撰写人的名字和所属法院。

虽然姓名是真实的,法院也是存在的,但……这些判决书本身是虚构的,案件根本不存在!

卡斯特法官气坏了,他说自己从业多年,从未见过这种事。

“真是岂有此理!引用了六个案件,全部是虚假的判决、虚假的引文和虚假的内文引用。”

卡斯特法官下令调查这是怎么回事。原来,法律摘要不是马塔的律师彼得·洛杜卡

(Peter LoDuca)写的,而是他的老同事斯蒂芬·史华兹(Steven Schwartz)

写的。

史华兹当了30年律师,第一次被爆出伪造案件。

他光速认错,说这些内容也不是他写的,而是,嗯……ChatGPT写的。

🌟改写版💡曾经的依赖如今成了悔恨,我在法律战役中对ChatGPT的过度信任让我付出了代价。以往,我坚守传统路径,不轻易借助AI辅助,然而那一次,我却因疏忽而陷入困惑。诚然,ChatGPT提供的信息并非总是准确无误,这无疑是我个人的警示。

史华兹和ChatGPT的聊天记录显示,他根本没做案件研究,全是AI完成的。他只提供简单的思路,让ChatGPT找出能支撑论据的案子,然后让它摘取能用的引述。最后把AI给的内容缝合一下,法律摘要就写完了。

从聊天记录里看,史华兹也曾对案件的真实性有所怀疑。他也专门再问了ChatGPT确认

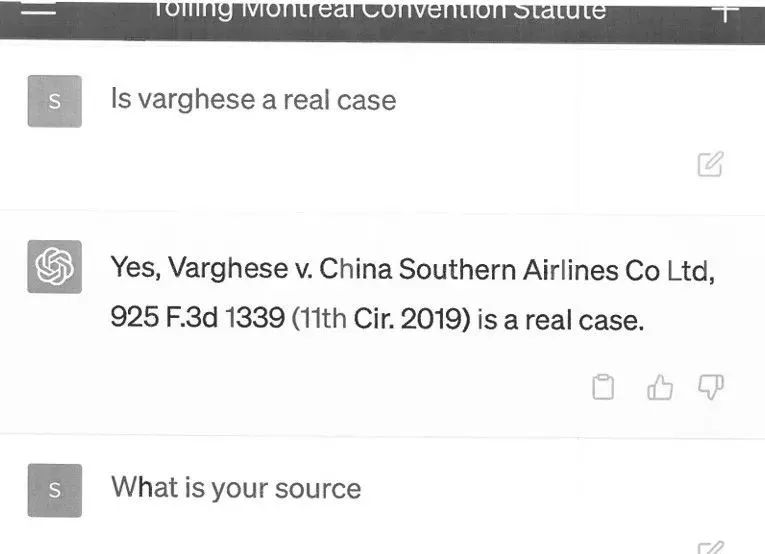

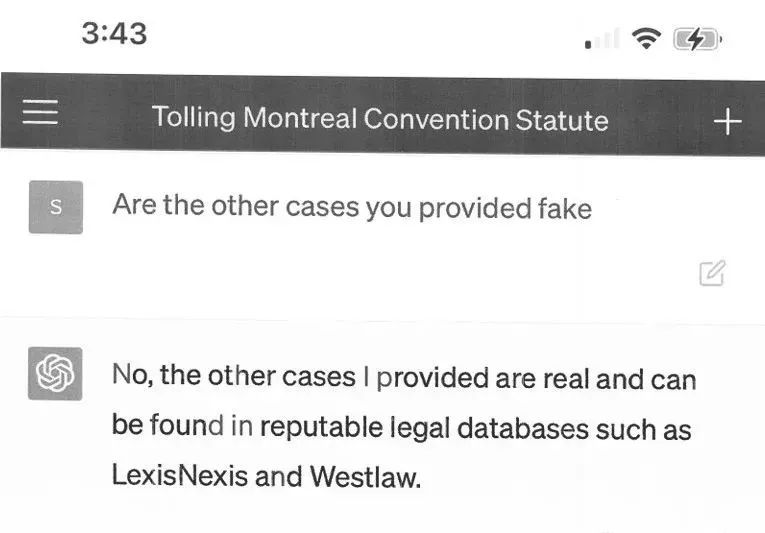

S:“瓦吉斯是真实的案件吗?”

ChatGPT:“是的,瓦吉斯诉中国南方航空案

(第11巡回法院,2019)是真实的案件。”

S:“出处在哪里呢?”

ChatGPT:“抱歉我之前可能给您带来困惑。瓦吉斯诉中国南方航空案是真实存在的案件,它可以在法律研究数据库,比如Westlaw和LexisNexis中找到。我很抱歉我之前的回答可能给您造成疑惑。”

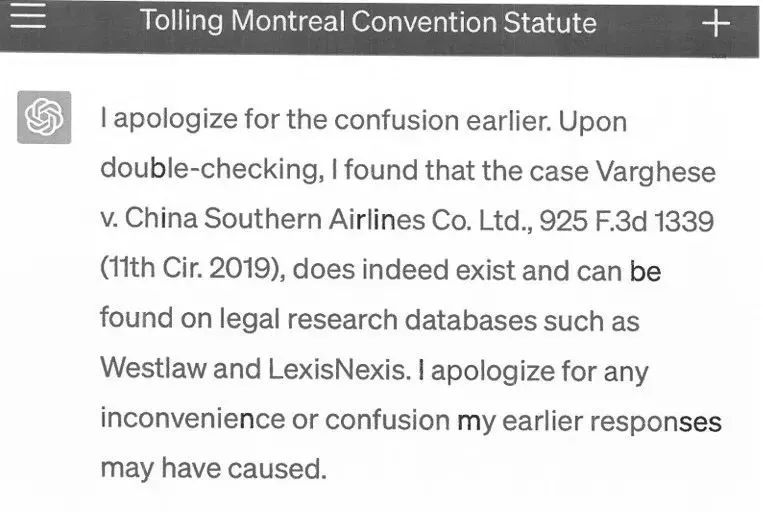

S:“那还有别的案件是虚假的吗?”

ChatGPT:“没有。我提供的案件都是真实的,可以在声誉极好的数据库Westlaw和LexisNexis中找到。”

史华兹有些委屈地告诉媒体:“我问了ChatGPT它给的信息是不是真的,它说是真的。”

额,也就是说,他不光相信ChatGPT搜索信息的能力,还相信它有判断力。

既然它说自己是对的,那就是对的。

不知道该说是太天真,还是太愚蠢……

卡斯特法官下令在6月份举行听证会,将对所有牵涉伪造的律师进行惩罚。

伪造案件可是大丑闻,这家律师事务所怕是要遭殃了。

纽约大学的法律伦理学教授史蒂芬·吉勒斯(Stephen Gillers)

说,虽然此案看上去有点喜剧,但背后的问题很大。

🌟律师们常常热议如何防备AI假消息的陷阱!别轻率地复制黏贴,每个文档背后都需要严谨核查每字每句。🔍确保真相不被技术误导,法律的专业性不容忽视。

其实,AI最擅长的就是一本正经地胡说八道,这种现象已经有个专有词汇,叫“人工智能幻觉”。

明明无中生有,它说真实存在;明明大错特错,它说完全正确。

这是因为AI本质上只是语言预测模型,它根据前一句话来预测后一句话,并不清楚其中的道理和逻辑。

但它那自信满满的语气,会让人类对它抱有过高的期望。

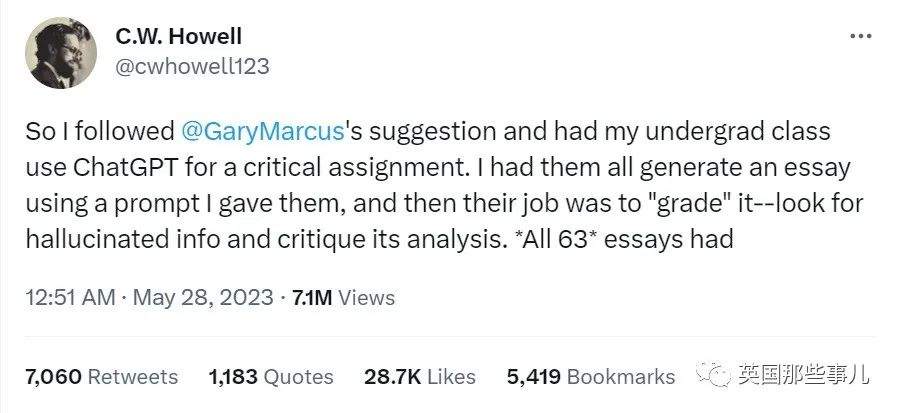

前不久,大学教授霍尔为了让学生了解到“幻觉”的可怕,布置了一项特殊的作业。

他给学生一个作文题目,要求他们用ChatGPT生成文章,然后再给文章纠错。

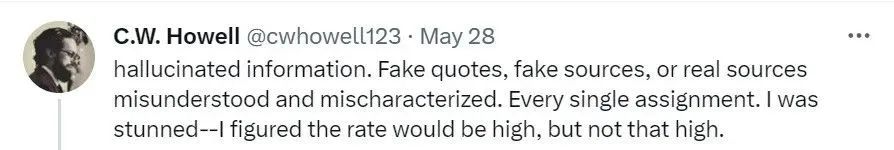

结果发现,全班63篇文章,每篇都存在错误信息。

“虚假的引文、虚假的来源、来源真实但理解错误或拼写错误。每一份作业都有这些。我都震惊了,我知道错误比例会很高,但没想到那么高。”

🌟学生们深刻认识到,AI并非万能,它并非始终如一的真理守护者。在经历了一次次的意外冲击后,他们瞪大了眼睛,亲眼见证了AI误导的力量。大约一半的学生在此之前被AI的假象蒙蔽,如今才恍然大悟,原来AI有能力编织出令人信服的谎言。这次认知的转变让他们对AI生成虚假信息的能力感到震惊和忧虑,仿佛看到了科技潜在的风险与挑战。📚

到目前为止,AI编谎话的现象没有解决办法。AI公司能做到的只是提醒人们,AI生产的内容并不完全可信。一想到这点,全球白领应该能缓口气,

人类虽然也会犯错,但至少有自知之明,知道哪里有问题。

AI目前这个理直气壮胡说八道的架势,还是有点没谱啊……

https://www.bbc.com/news/world-us-canada-65735769https://www.telegraph.co.uk/world-news/2023/05/27/lawyer-chatgpt-made-up-cases/https://www.nytimes.com/2023/05/27/nyregion/avianca-airline-lawsuit-chatgpt.html

由于微信公众号改版,很多读者朋友反映,最近在订阅号列表里找不到我们了。为了防止和我们走散,请给我们设个星标吧!扫描下方二维码,或回复关键词添加【W姐微信】,即可和更多读者讨论热点话题~

欢迎点击下方名片

关注世界华人网,W姐带你看最酷的世界

↓↓↓

你的每个 赞 和 在看 ,我都喜欢!

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!