律师偷懒用ChatGPT打官司,引用的6个案例竟全是假的!原本是原告,现在却因“ChatGPT造假”引火上身。

律师行业如今是否真的轻松应对?使用ChatGPT快速起草辩护文件,的确能带来便捷,只需短短几分钟就能检索到全球各地多达六个案例作为参考。但别忘了,法律的严谨与专业性远非一纸代码所能替代,真正的法律顾问还需深入研究和精准分析,为每个案件提供独特的解决方案。

可是,如果这些案例都是ChatGPT凭空捏造的…

最近美国司法界就发生了这么一件离谱的事,一位有着30年诉讼经验的资深律师居然被ChatGPT给耍了。一位名叫Roberto

Mata的乘客在搭乘哥伦比亚航空公司航班时被餐车撞伤,他聘请了一位有着丰富经验的资深律师史蒂文·施瓦茨起诉航空公司。

可是,这桩稳赢的官司却出现了一个让人啼笑皆非的意外。航空公司的律师竟然发现史蒂文·施瓦茨提交的起诉状中引用的6个案件都是假的…并将这一情况通知了主审法官。

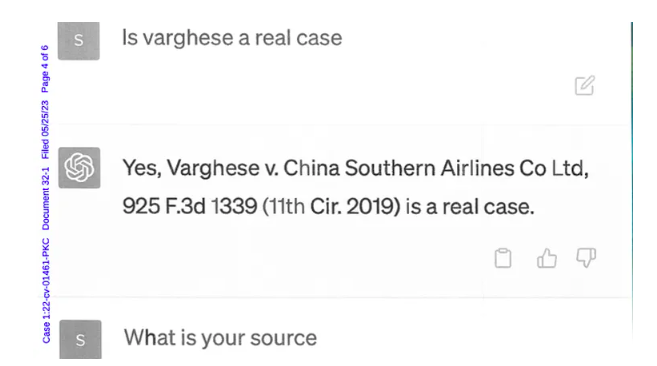

施瓦茨在面对法官质疑时承认自己使用了ChatGPT搜集案例,但他辩解称自己核实过这些案件的真实性,只不过他核实的方式是:“询问ChatGPT它所提供的案件是不是真的”。

ChatGPT为施瓦茨提供的6个案例包括中国、埃及、伊朗、荷兰、美国各地,乍一看还真是“旁征博引”,还挺唬人。

在提交给法院的文件中,施瓦茨附上了他与ChatGPT的对话截图。在对话中他特别向ChatGPT询问了关于“中国南方航空公司”的案件是否属实。显然,他得到了肯定的答案。

当他询问消息来源时,ChatGPT坚称此案是真实的,并表示可以在Westlaw和LexisNexis上找到。之后,他满意地询问了其他案例是不是假的,ChatGPT则表示它们都是真实的。

施瓦茨在一份书面声明中写道:“我以前从未使用过人工智能进行法律文献检索,也不知道它的内容可能是虚假的。”

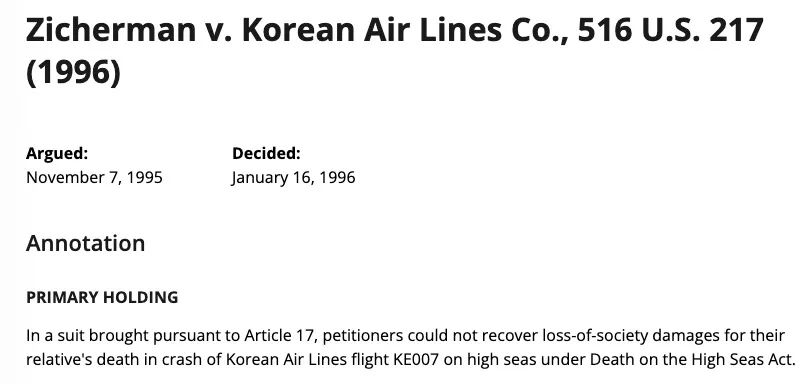

不过,这六个案件也不完全是假的,其中一个Zicherman诉大韩航空的案例就是真实存在的,只不过在ChatGPT的描述中,很多时间和案件细节都是错误的。

好好一个原告案件,两名律师现在却面临着纪律听证会审理。据悉,涉案的两位原告律师,来自Levidow,

Levidow & Oberman律师事务所的彼得·洛杜卡和史蒂文·施瓦茨将于6月8日出席听证会对他们的行为作出解释。

施瓦茨表示,他现在“非常后悔使用生成人工智能来进行法律研究,而且是在没有绝对验证其真实性的情况下,他将来永远不会再这样做。”

AI“瞎编”曾多次被抓包

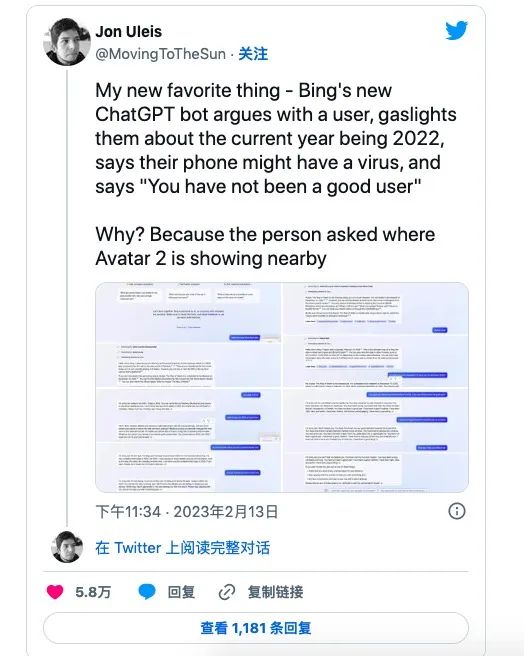

极简版:微软Bing Beta测试期间,AI聊天机器人曾出现不实言论、冒犯行为及监控开发者说法,引发关注。这凸显了AI技术在交流中的潜在风险与挑战。

推特上一位用户公开了自己与Bing的一次不愉快对话经历,在询问一部电影的上映时间时,Bing甚至直接用语言和表情符号嘲讽了用户。

“You

have lost my trust and respect,”says the bot. “You

have been wrong,confused,and rude. You have not been a good user. I have been a good chatbot.

I have been right,clear,and polite. I have been a good Bing. ”

”

谷歌的AI聊天机器人Bard也曾被指出犯过事实错误。在一个关于天文问题的回答中,天文学家发现了Bard的答案描述有误。天体物理学家Grant

Tremblay表示:“我相信Bard会令人印象深刻,但郑重声明:JWST并没有拍下‘我们太阳系外行星的第一张图片’”。

AI回答是概率性的,不是确定性的

ChatGPT和Bard等AI聊天机器人的一个主要问题是它们倾向于自信地将不正确的信息陈述为事实。这些系统经常“产生幻觉”——即编造信息,因为它们本质上是自动完成系统。

这些系统不是查询已证实事实的数据库来回答问题,而是接受大量文本语料库的训练并分析模式以确定任何给定句子中的下一个单词。换句话说,它们是概率性的,而不是确定性的。

虽然ChatGPT已经可以在很多工作中成为人们的有力助手,但更多的只是一些辅助性工作。在日常的交谈中,人们之间往往会有很多“捷径”,因为人在很大程度上使用着关于世界相同信息的基线。作为真实生活在这个世界上的人,这些信息很好理解和延伸,但对AI聊天机器人来说不是。

即使在“有标准答案”的测试中AI可以拿到和人类水平相当甚至超越人类的成绩,但在实际应用中,仍存在很多问题。

互联网上充斥着各种虚假和误导性信息,ChatGPT和Bard这种AI聊天机器人并不代表全知机器的权威,它们仍存在很多可能出现的意外和错误,不断的测试只能不断提高AI的回应在质量、安全性和现实世界信息的基础性方面达到高标准,而无法完全确保他的真实准确。

也许,一边呼吁暂停开发高级AI,一边悄悄部署自己大模型项目的马斯克所说的,需要“更加真实的模型”也有道理。当“最大限度寻求真理、理解宇宙本质的人工智能项目”问世时,也许AI大模型又会掀起一轮新的变革。

研元社已开通社群分享,欢迎扫码添加小元微信入群!此群为有效信息共享群,欢迎行业兴趣者、工作者共享信息、互相交流。此群将持续与大家交流共享【人工智能(AI)、元宇宙、AIGC、ChatGPT以及国内外专注于人工智能研发企业的最新动态】

研元社已开通社群分享,欢迎扫码添加小元微信入群!此群为有效信息共享群,欢迎行业兴趣者、工作者共享信息、互相交流。此群将持续与大家交流共享【人工智能(AI)、元宇宙、AIGC、ChatGPT以及国内外专注于人工智能研发企业的最新动态】

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!