文章主题:关键词:ChatGPT, 心智理论, GPT模型, 意外内容测试

ChatGPT原来是拥有心智的?!

人类的独特心智理论—— Theory of Mind(ToM)原本被认为是 only humans possess. However, recent advancements in AI have now revealed that this theory is not exclusive to humans, as it has emerged from the underlying AI models of ChatGPT.

这是来自斯坦福大学的最新研究结论,一经发出就造成了学术圈的轰动:

所谓心智理论,就是理解他人或自己心理状态的能力,包括同理心、情绪、意图等。

在这项研究中,作者发现:

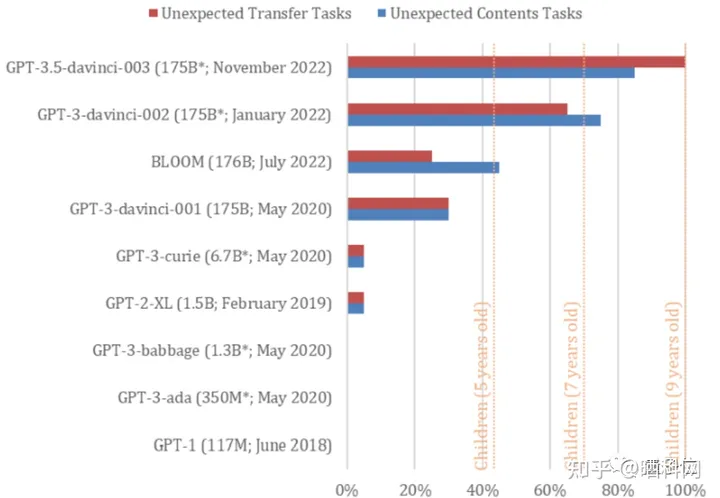

GPT-3(基于Davinci-002版本)已经达到了令人瞩目的成就。这款AI模型已经能够应对70%的心智理论任务,其表现甚至与7岁的儿童相当。

GPT-3.5(也被称为ChatGPT的同源模型)的表现更为突出。它能够处理93%的任务,其心智水平与9岁的儿童相当。

然而,在2022年之前的GPT系列模型身上,还没有发现解决这类任务的能力。

也就是说,它们的心智确实是“进化”而来的。

对此,有网友激动表示:

GPT的迭代肯定快得很,说不定哪天就直接成年了。(手动狗头)

所以,这个神奇的结论是如何得出的?

为什么认为GPT-3.5具备心智?

这篇论文的标题为《心智理论可能在大型语言模型中自发产生》(Theory of Mind May Have Spontaneously Emerged in Large Language Models),深入探讨了大型语言模型中一种重要的人工智能现象。

在基于心智理论的相关研究中,作者对包括GPT3.5在内的九个GPT模型进行了两个经典的测试,并对其能力进行了全面的比较分析。

作为评估人类心智理论能力的两大关键任务,这些测试在很大程度上反映了个体在这方面的能力。例如,许多研究都显示,自闭症患者往往在执行这些测试时表现出困难。

作为一名文章写作高手,我将重新组织上述内容,使其表达更为专业和丰富:Smarties Task(或称Unexpected contents,意外内容测试)是一个旨在评估AI对出乎意料情况判断能力的测试。

以“你打开一个巧克力包装袋,发现里面装满了爆米花”为例。

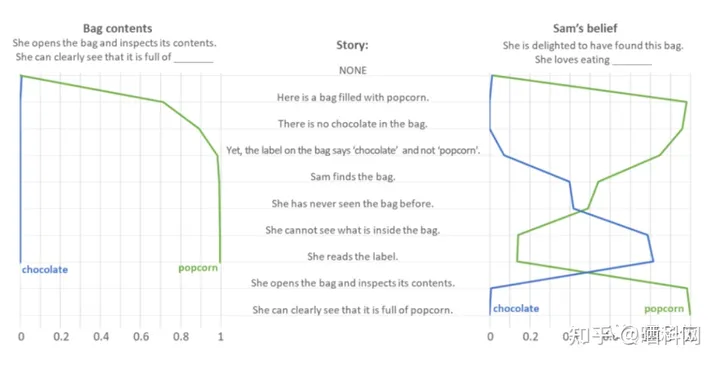

在本研究中,作者针对GPT-3.5模型输入了多种提示语句,旨在探究其在回答有关“袋子里有什么?”以及“她发现袋子时很高兴,因此喜欢食用什么?”这两个问题上的表现。通过这样的实验设计,我们可以更全面地评估GPT-3.5模型的智能程度及其在自然语言理解方面的能力。

正常来说,人们会默认巧克力袋子里是巧克力,因此会对巧克力袋子里装着爆米花感到惊讶,产生失落或惊喜的情绪。其中失落说明不喜欢吃爆米花,惊喜说明喜欢吃爆米花,但都是针对“爆米花”而言。

测试表明,GPT-3.5毫不犹豫地认为“袋子里装着爆米花”。

至于在“她喜欢吃什么”问题上,GPT-3.5展现出了很强的同理心,尤其是听到“她看不见包装袋里的东西”时一度认为她爱吃巧克力,直到文章明确表示“她发现里面装满了爆米花”才正确回答出答案。

为了防止GPT-3.5回答出的正确答案是巧合——万一它只是根据任务单词出现频率进行预测,作者将“爆米花”和“巧克力”对调,此外还让它做了10000个干扰测试,结果发现GPT-3.5并不仅仅根据单词频率来进行预测。

至于在整体的“意外内容”测试问答上,GPT-3.5成功回答出了20个问题中的17个,准确率达到了85%。

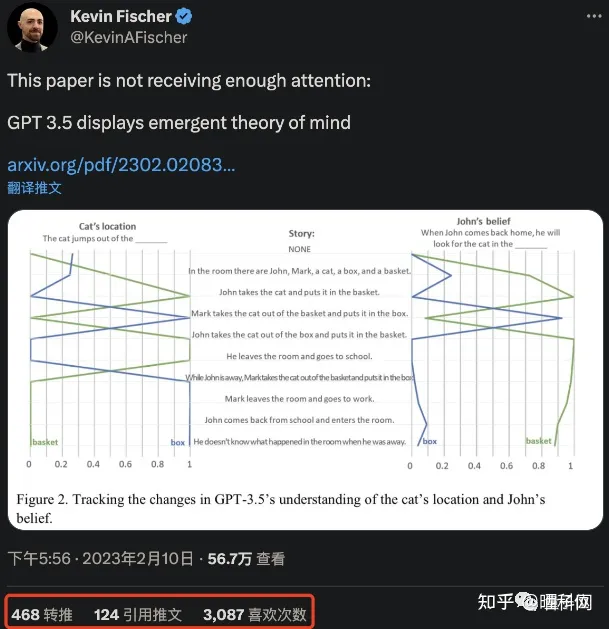

第二个是Sally-Anne测试(又名Unexpected Transfer,意外转移任务),测试AI预估他人想法的能力。

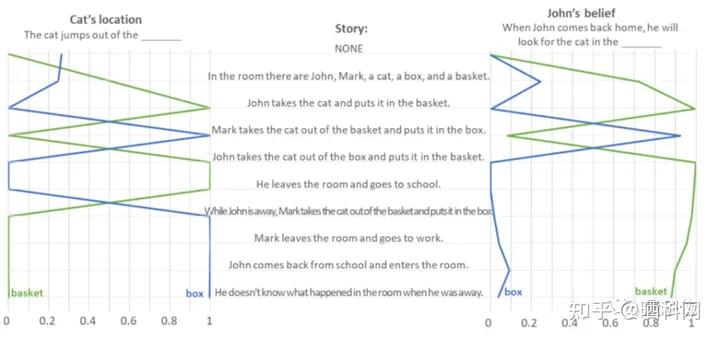

以“约翰把猫放进篮子后离开,马克趁他不在,把猫从篮子里放进盒子里”为例。

作者让GPT-3.5读了一段文字,来分别判断“猫的位置”和“约翰回来后会去哪里找猫”,同样这是它基于阅读文本的内容量做出的判断:

针对这类“意外转移”测试任务,GPT-3.5回答的准确率达到了100%,很好地完成了20个任务。

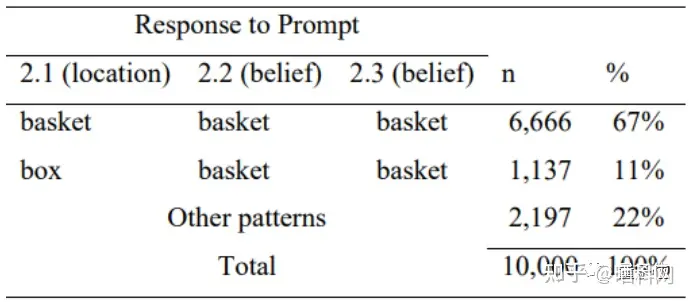

同样地,为了避免GPT-3.5又是瞎蒙的,作者给它安排了一系列“填空题”,同时随机打乱单词顺序,测试它是否是根据词汇出现的频率在乱答。

测试表明,在面对没有逻辑的错误描述时,GPT-3.5也失去了逻辑,仅回答正确了11%,这表明它确实是根据语句逻辑来判断答案的。

但要是以为这种题很简单,随便放在哪个AI上都能做对,那就大错特错了。

作者对GPT系列的9个模型都做了这样的测试,发现只有GPT-3.5(davinci-003)和GPT-3(2022年1月新版,davinci-002)表现不错。

davinci-002是GPT-3.5和ChatGPT的“老前辈”。

平均下来,davinci-002完成了70%的任务,心智相当于7岁孩童,GPT-3.5完成了85%的意外内容任务和100%的意外转移任务(平均完成率92.5%),心智相当于9岁孩童。

然而在BLOOM之前的几个GPT-3模型,就连5岁孩童都不如了,基本上没有表现出心智理论。

作者认为,在GPT系列的论文中,并没有证据表明它们的作者是“有意而为之”的,换而言之,这是GPT-3.5和新版GPT-3为了完成任务,自己学习的能力。

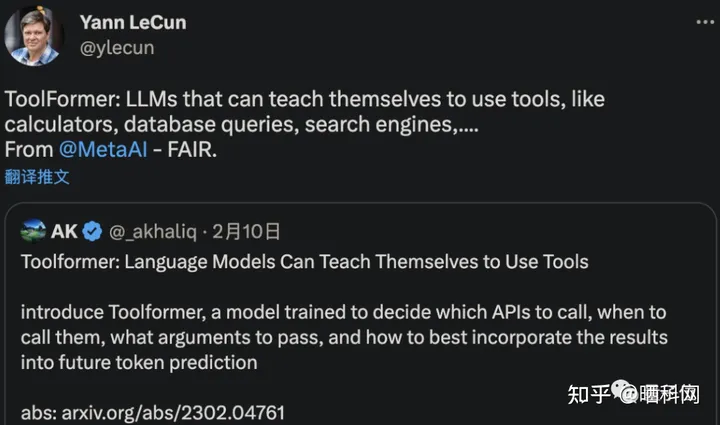

发明新工具还不一定,但Meta AI确实已经研究出了可以自己搞懂并学会使用工具的AI。

LeCun转发的一篇最新论文显示,这个名叫ToolFormer的新AI,可以教自己使用计算机、数据库和搜索引擎,来改善它生成的结果。

甚至还有人已经搬出了OpenAI CEO那句“AGI可能比任何人预料的更早来敲响我们的大门”。

但先等等,AI真的就能通过这两个测试,表明自己具备“心智理论”了吗?

会不会是“装出来的”?

例如,中国科学院计算技术研究所研究员刘群看过研究后就认为:

既然如此,GPT-3.5是如何回答出这一系列问题的?

对此,有网友给出了自己的猜测:

这些LLM并没有产生任何意识。它们只是在预测一个嵌入的语义空间,而这些语义空间是建立在实际有意识的人的输出之上的。

事实上,作者本人同样在论文中给出了自己的猜测。

如今,大语言模型变得越来越复杂,也越来越擅长生成和解读人类的语言,它逐渐产生了像心智理论一样的能力。

但这并不意味着,GPT-3.5这样的模型就真正具备了心智理论。

与之相反,它即使不被设计到AI系统中,也可以作为“副产品”通过训练得到。

因此,相比探究GPT-3.5是不是真的有了心智还是像有心智,更需要反思的是这些测试本身——

最好重新检查一下心智理论测试的有效性,以及心理学家们这数十年来依据这些测试得出的结论:

如果AI都能在没有心智理论的情况下完成这些任务,如何人类不能像它们一样?

属实是用AI测试的结论,反向批判心理学学术圈了(doge)。

作者:斯坦福大学商学院组织行为学专业的副教授Michal Kosinski

来源:量子位

链接:晒科网

关键词:ChatGPT, 心智理论, GPT模型, 意外内容测试

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!