文章主题:关键词:数据挖掘, 情感分析, ULMFiT

Universal Language Model Fine-tuning for Text Classification

Introduction

🚀随着科技革新,数据洪流如雨后春笋般激增,各领域信息丰富无比。在这个数字化时代,数据挖掘的重要性不言而喻,它像一把精准的钥匙,解锁海量信息的秘密。特别是在金融和安全领域,舆情监控与公共事件预警(特朗普战胜希拉里,大数据与人工智能的预测结果与传统共识形成鲜明对比)就证明了其价值所在。电商平台中,用户观点的深度挖掘和倾向性分析同样离不开数据挖掘技术的智慧引导。文本数据挖掘,自2000年起经历了爆发式增长,如今已成为自然语言处理与数据融合的核心领域,备受瞩目。而情感分析(😍Sentiment Analysis),作为text mining的核心议题,更是引领了这一领域的前沿探索。

Sentiment analysis本质上可以看做回归问题(1-10,数字的大小表示情感的强烈程度)或分类问题(二分类:positive or negative,多分类:positive、negative and neural),早期则是以模式识别中的SVM、最大熵、朴素贝叶斯等模型为主。近年来深度学习技术的强势崛起,以Embedding技术与RNN网络最早被用于至NLP的各类问题中,然而其并不能很好的解决long-term dependencies的问题,故又发展出了长短时记忆神经网络LSTM,其在RNN的基础上引入了“门”的概念,通过“三门”控制信息的输入、输出与丢失。然而LSTM过于复杂,因此又有学者将LSTM中的输入门与遗忘门合并为更新门以简化网络结构减少参数同时保证结果的精度。然而当句子长度过长时(超过30个词)LSTM的性能也会急剧下降,因此以Encoder-Decoder为框架(解决网络输入输出长度不一需对齐的问题,如机器翻译任务)的attention mechanism应运而生,其本质上是对各个输出结果与输入序列进行加权求和,以动态调整中间编码向量 CC 获得注意力,该方法有效解决了长时依赖的问题。上述模型的个时刻的输出均需要依赖上一时刻的state,因此计算速度较慢且不易并行,故Google又提出了Transform,Transform本质上是一种编码器,其输出不需依赖上一时刻的state,可以很好的并行。此外其通过self-attention编码序列各个部分的依赖关系的操作,又可以看做为句法结构分析,因此该方法在性能上获得了较大的提升。2017年到21018年ELMo、GPT以及Bert模型先后被提出,融入了大量外部信息的pre-train方法被成功应用至NLP的各个任务中(Embedding技术可以看做shallow的pre-training,而在CV领域以ImageNet为基础的预训练方法在各个任务如classification、object detection和semantic segmentation中早已取得了巨大的成功。对于NLP,pre-training为何现在才出现的原因主要有两点解释,即缺乏大量、丰富且质量较高的语料以 及NLP个任务差别较大)。详细介绍可以参考我的这篇笔记

🌟🚀GPT2.0的升级版,相较于BERT,它巧妙地融入了更多丰富的外部信息,引领技术潮流。而在情感分析这一专业领域,17-18年间的研究也不乏亮点——通过在大规模数据集上大放异彩的预训练,然后针对性地优化,在特定数据集上达到顶尖水平,比如ULMFiT和bmLSTM等模型。🚀🏆

🌟 ULMFiT🚀 —— 预训练语言模型的革命性突破!📈通过Wikitext-103的大规模训练,ULMFiT展示了惊人的能效,将文本分类任务的错误率锐减了18-24个百分点,这相当于在精度上超越了使用x100数据集的传统模型。它在小数据集上的表现更是亮眼,精准度不逊色于大型数据集,避免了常见的过拟合问题,展现出了卓越的泛化能力。🌍欲了解更多关于如何利用这种高效技术提升文本分析效率的秘密?只需关注我们,让ULMFiT引领你的语言学习新时代!👩💻👨💻 #预训练模型 #小数据优势 #无过拟合

ULMFiT

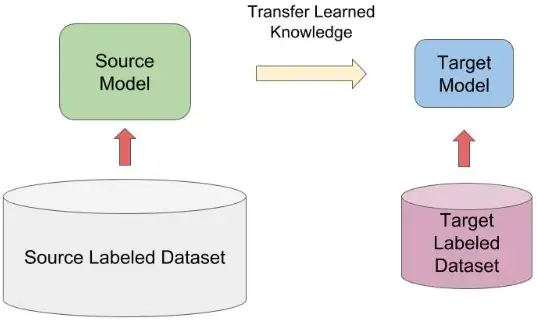

🌟💡迁移学习中的#预训练模型Fine-Tuning法是提高效率的秘密武器!特别是在小数据集如多语言语料丰富的情况下,它能大放异彩,让任务训练更轻松。但对于NLP领域,虽然CV广泛应用,这项技术却鲜有触及。🚀🌍通过微调,不仅优化特定任务,还能促进相似任务的快速上手,实现跨领域的知识迁移。别忘了,SEO友好词汇在此处等你发现!📚💪

图1. Transfer Learning

🌟 ULMFiT, the game-changer in NLP, elevates AWD LSTM to new heights by turning it into an exceptional pre-training framework. Its prowess is evident as it dominantly outperforms competitors in text classification tasks, setting the bar for state-of-the-art excellence. 🚀Developed on the foundation of AWD LSTM’s language modeling prowess, ULMFiT ingeniously fine-tunes and refines, harnessing its potential to deliver unparalleled accuracy. By seamlessly integrating this cutting-edge technology into various applications, it revolutionizes the way we classify texts, boosting search engine optimization and user engagement. 📊 SEO友好的词汇和 phrases are strategically incorporated to optimize your content for search engines.Experience the power of ULMFiT firsthand by exploring its impressive track record and delving into the depths of its research-driven methodology. Embrace the future of language modeling with this trailblazing model! 🔍

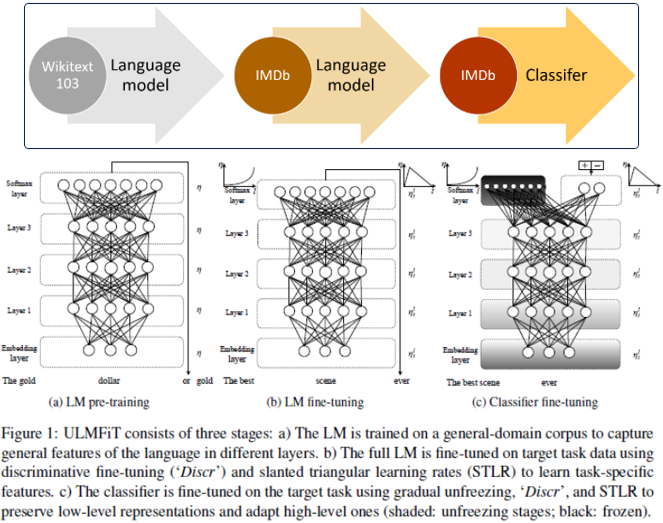

图2. ULMFiT Pre-training

其预训练过程主要分为3个阶段:

以AWD-LSTM为backbone在Wikitext-103上预训练LM;在IMDB等小规模数据集(数据集较大pre-training的优势将不再明显,多次试验以及恺明rethinking ImageNet Pre-training已证明)上对LM进行fine-tune;Add few layers再次fine-tune使得模型满足当前任务(fine-tune两个基本手段修改当前任务满足pre-training模型,修改pre-training模型满足当前任务);

Phase Ⅰ.

🌟🚀改写版:在文本处理领域,我们采用🔥AWD-LSTM🔥技术进行深度学习模型的初始化,这是一种广受认可的预训练策略,特别是在WikiText-103这个海量文献宝藏上。这项工作通过优化3层LSTM结构,对28,595篇精心整理的Wikipedia文章进行了强大的语言建模训练,总词汇量高达1亿个单词。AWD-LSTM的独特之处在于它结合了【SGD平均化】与【dropout策略】,这两者相互强化,确保模型在复杂任务中具备出色的泛化能力。🚀

①Averaged SGD。ASGD是指先训练模型至一定的epoch,此后再将每一轮训练的权值进行平均作为最后的权值。对于general SGD权值的更新公式为:

(1)wk+1=wk−γk∇f(wk)w_{k+1}=w_k-\gamma_k\nabla f(w_k)\tag{1}

其中 kk 即为迭代次数, wkw_k 即为第 kk 次iteration的权值,而在ASGD中其模型的权值如下:

(2)w=1K−T+1∑i=TKwi w=\frac{1}{K-T+1}\sum_{i=T}^Kw_i\tag{2}

上式中, KK 为迭代总次数, TT 为指定的迭代次数( TT 之后的迭代需进行平均)。式(2)即表明权值 ww 为 T∼K−TT\sim K-T 次迭代权值 ww 的平均值。

②Dropout。Dropout是指对 t−1t-1 和 tt 时刻隐层的全连接矩阵进行Dopout操作,防止过拟合。

Phase Ⅱ.

阶段二在LM进行fine-tuning,该过程仅需要对权值进行微调而不需彻底训练网络,其目的是使模型不要“忘记”之前习得的特征,对此作者设计了两个tricks;①discriminative fine-tuning,②slanted triangular learning rates。

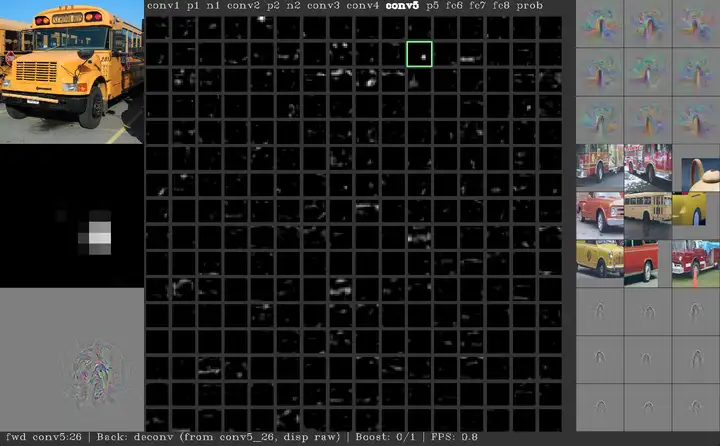

①discriminative fine-tuning。discriminative fine-tuning背后的动机即为模型中不同的layers将捕获、表征不同类型的特征,如下:

图3. layer representation

如图3,shallow layers表示的特征更加具体,而deep layers表示的特征则更加抽象,在NLP网络中浅层则偏向语法信息而高层则偏向语义信息。因此浅层的layer需要较少次数的fine-tuning,而随着网络层数的增加,其需要fine-tuning的次数将不断上升,故对于不同层设计不同的学习率:

(3)θtl=θt−1l+ηl∇θlJ(θ) \theta_t^l=\theta_{t-1}^l+\eta^l\nabla_{\theta^l}J(\theta)\tag{3}

上式中 ηl\eta^l 即为 ll 层的学习率,在原文中作者通过指定最后一层学习率后浅层学习率在此基础上进行调整:

(4)ηl−1=ηl2.6\eta^{l-1}=\frac{\eta^l}{2.6}\tag{4}

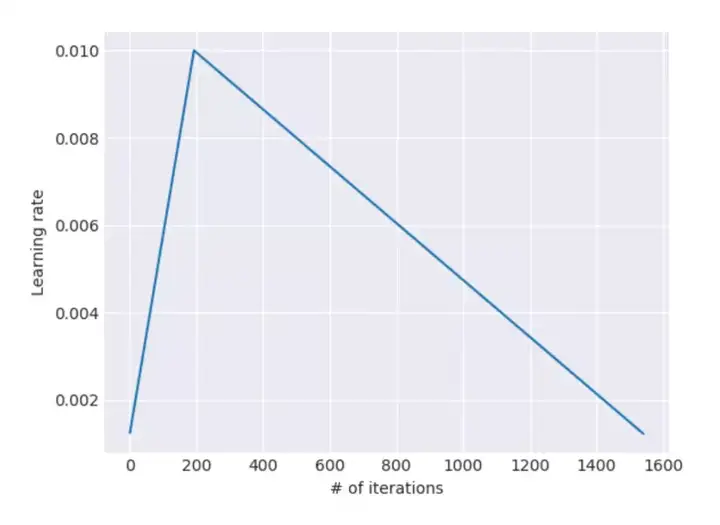

②Slanted Triangular Learning Rates

由于预训练的语料与目标语料在分布上有所差异,因此在fine-tuning阶段需要调整模型参数以适应target task,故作者提出了改进的三角学习率(STLR,triangular learning rates, Smith 2017的改进),即首先使学习率快速增长使得模型对于目标任务快速调整参数以达到suitable region,然后再缓慢下降逐渐调整使其更好的适应目标,同时使训练更加平稳:

图4. Slanted Triangular Learning Rates

(5)cut=⌊T⋅cutfrac⌋p={t/cut,if t < cut1−t−cutcut⋅(1/cutfrac−1),otherwiseηt=ηmax⋅1+p⋅(ratio−1)ratiocut=\lfloor T\cdot cut_frac \rfloor\\ p=\begin{cases} t/cut, & \text{if t < cut}\\ 1-\frac{t-cut}{cut\cdot (1/cut_frac-1)}, & \text{otherwise} \end{cases}\\ \eta_t=\eta_{max}\cdot \frac{1+p\cdot (ratio-1)}{ratio}\tag{5}

上式中, TT 为总迭代次数, cut_fraccut\_frac 是学习率增加的迭代次数, cutcut 是学习率减少的次数;

一般来说 cut_frac=0.1,ratio=32,ηmax=0.01cut\_frac=0.1,ratio=32,\eta_{max}=0.01 。

Phase Ⅲ.

阶段三为classifier fine-tuning,这里在原始的网络中新增加两层全连接层,同时加入batch norm和dropout操作,并使用ReLU作为中间层激活函数,最后经过softmax输出分类的概率分布。此外,在精调过程中作者还使用了如下策略:

Concat Pooling

在第一层全连接后使用pooling操作,另外考虑到文档级的文本分类任务其关键信息可能出现在任意处且一般仅为少数关键词,因此若只使用最后一层全连接层信息将损失严重,故在满足GPU Memory的前提下作者对尽可能多的隐层进行max-,mean-pooling,并将其拼接至最后的state中。

Gradual Unfreezing

Fine-tuning十分铭感,其在此过程中经常会出现过度精调而使得网络忘记先验信息的情况,出现过拟合的风险。因此作者设计gradual unfreezing fine-tuning操作,即从最后一层开始unfreez并进行精调,此后由后向前unfreez并精调所有层。

BPTT for Text Classification (BPT3C)

类似于BPTT,作者设计了BPT3C以在large documents上进行模型精调,对此首先将文档分为长度为 bb 的batches,并在每个batch训练时记录mean和max池化,同时后一个批次参数的初始化为前一个批次的参数,这样梯度会被反向传播到对最终预测有贡献的batches。

Bidirectional language model

分别训练和精调前向、后向语言模型,最终模型的输出结果则由这两个模型的预测平均值决定。两者结合后结果有0.5-0.7的提升。

Experiments

通过上述操作的结合ULMFiT在小规模数据集上取得了惊人的效果,如下:

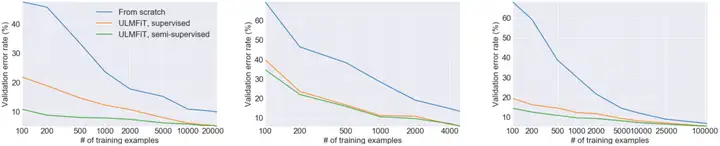

图5. IMDB sentiment analysis task

从上图可以明显看出,当样本数量较少时ULMFiT的优势尤为明显,其仅通过100个样本就能达到未经pre-training20k样本的精度。

在自让语言处理中pre-training的工作相比CV领域出现的较晚,这一方面是由于其缺乏大规模高质量的数据,另一方面是因为NLP的各种任务差别较大。然而随着Bert的出现,NLP各项任务的记录被逐一刷新,毫无疑问融入更多的外部信息对于精度的提高有着显著的影响,然而数据的准备与训练需要大量的时间成本和算力,这将成为各个互联网寡头间的“军备竞赛”,而对于我们来说跟多的则是要探究如何将先验知识信息更加有效的融入至网络中,而知识图谱似乎给出了一定的解决方案。

有关模型的代码部分可以参考

Reference