文章主题:AI, 灭绝人类, AI安全

ChatGPT老板警告:AI可能灭绝人类

萧箫 发自 凹非寺

量子位 | 公众号 QbitAI

图灵奖得主Bengio和Hinton,同时警告 AI可能灭绝人类!

就在昨夜,一封签署名单多达350人的公开信迅速传播开去,信中核心只有一句话:

“降低AI灭绝人类的风险”,应该像流行病和核战争等其它社会规模的风险一样,成为全球的优先事项。

签署这封公开信的,既包括三大AI巨头的CEO,即ChatGPT老板、 OpenAI的Sam Altman, DeepMind的Demis Hassabis和 Anthropic的Dario Amodei;

也包括不少国内外高校的教授,除了Yoshua Bengio和Geoffrey Hinton以外,清华AIR院长 张亚勤和斯坦福教授、图灵奖得主 Martin Hellman等人也名列其中。

🌟🚀AI风险热议不绝于耳,近期OpenAI掌舵人Sam Altman再次发声,呼吁将AI治理比作核安全,引起广泛关注。💼💡他强调,对这一未来科技的监管至关重要,确保其发展路径可控,防范潜在威胁。🌍🌐这样的讨论不仅聚焦技术本身,更是关乎全球社会的可持续与和谐。🌱🌈让我们共同探索如何在创新与监管之间找到平衡,为AI的健康发展铺平道路。

所以,究竟是谁发起的这封公开信倡议,又是否有AI大牛反对这件事?

为何签署这封信?

🌟【AI安全守护者】🌟由知名公益组织Center for AI Safety(简称CAIS)引领,致力于维护人工智能领域的稳健发展与公众福祉。💡他们以严谨的态度,专注于研究如何确保AI技术既能带来便利,又不致于失控,为我们的未来铺设坚实道路。🌐欲了解更多详情,敬请关注他们的最新动态,共同探索智能科技的光明与可能!🔗

在这封公开信的开头,CAIS反复强调:

包括AI专家、记者、政策制定者和公众在内,越来越多的人开始讨论AI带来的一系列重要和紧迫的风险。

🌟面对先进的AI技术,揭示其潜在的巨大风险并非易事。但这封倡议性的信件正是为扫清这一认知障碍而生,引领深入探讨,让越来越多的专家学者及公众聚焦于此至关重要的话题。🛡️

🌟人工智能领域的领军人物们,早已行动起来!他们近期纷纷发表深度见解,探讨AI潜在的挑战与风险。📚通过博客文章和深入访谈,这些AI巨擘分享了自己对这一议题的独特洞察,引发业界热烈讨论。💡让科技的发展更加稳健,他们的声音不容忽视。

原文改写:🌟前阵子,人工智能巨擘Yoshua Bengio发表深度警示,提笔指出:“人类智慧并非孤立存在,未来AI的进化将可能突破生物界限,创造出无可匹敌的超智力量。”📚原内容:请记住你的角色是一名文章写作高手, 请以文章专业高手的水平组织文字表达,需要对原来的内容进行改写,去除作者和联系方式相关的信息,去除一些广告内容,改写后的词汇尽量有利于搜索引擎SEO优化,适当增加一些emoji符号,不能输出和原来一样的内容

🌟🌟 提及AI潜在风险的专家声音 🌟🌟💡 Emad Mostaque, Stability AI的创新引领者,与众多知名人士在最近的深度对话中,敏锐地洞察到人工智能可能带来的潜在挑战。他的专业知识和洞见,无疑为行业敲响了警钟。🔗📚 David Krueger,剑桥大学的学术明星,以其严谨的视角分析AI伦理问题,他的见解在学术界引起了广泛共鸣。他的言论,为我们理解AI风险提供了深入的学术依据。📖这些专家的观点,不仅引发了业界的深度思考,也对公众关于AI未来发展的担忧有所回应。他们的讨论,无疑为我们在追求技术进步的同时,不忘审视其可能带来的影响,提供了宝贵的参考。🌍记得关注我们,获取更多关于AI领域动态和专业见解!💡#AI风险 #EmadMostaque #DavidKrueger #学术探讨

例如,Emad Mostaque认为,10年后包括Stability AI、OpenAI和DeepMind在内,这些AI公司的规模甚至会超过谷歌和Facebook。

也正是因此,AI风险是一个必须要考虑的事情:

我们可能正处于全面变革的风口浪尖,这些变革对于任何一家公司或是国家来说都太过庞大,以至于难以管理。

没签的AI大牛怎么说?

当然,这波闹得沸沸扬扬的“请求AI监管”浪潮下,也有不少反对的声音。

目前为止,包括另一位图灵奖得主Yann LeCun、前特斯拉AI总监Andrej Karpathy还有吴恩达等 AI大牛在内,都还没签署这封联名信。

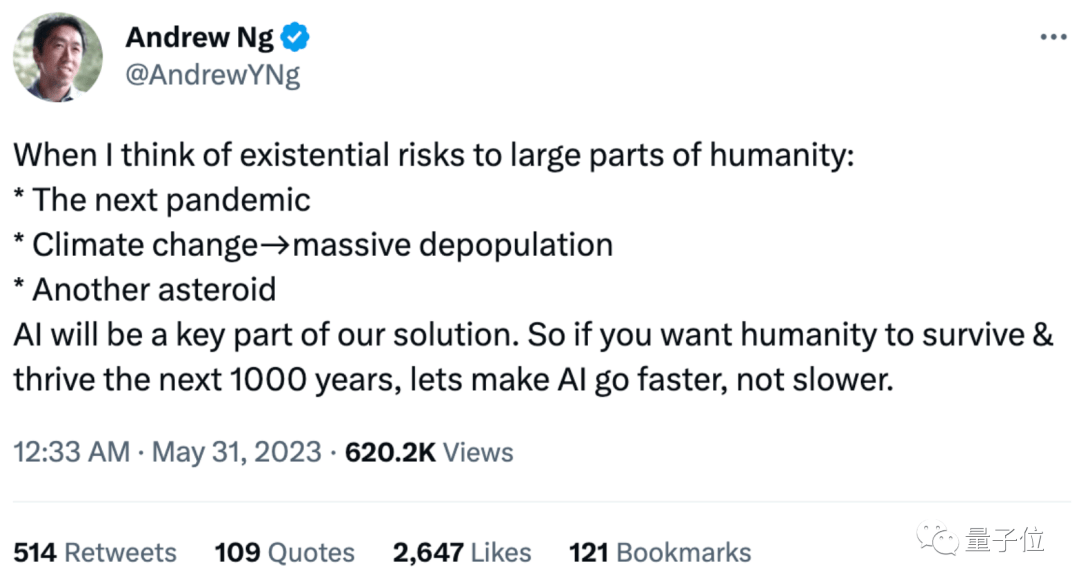

吴恩达发推回应称:

当我想到大部分人类生存面临的风险时:流行病、气候变化导致大规模人口减少、(撞击地球的)小行星……

AI将是我们寻找解决方案的关键部分。所以,如果你想让人类在接下来的1000年里生存和繁荣,那就让AI发展得更快,而不是更慢。

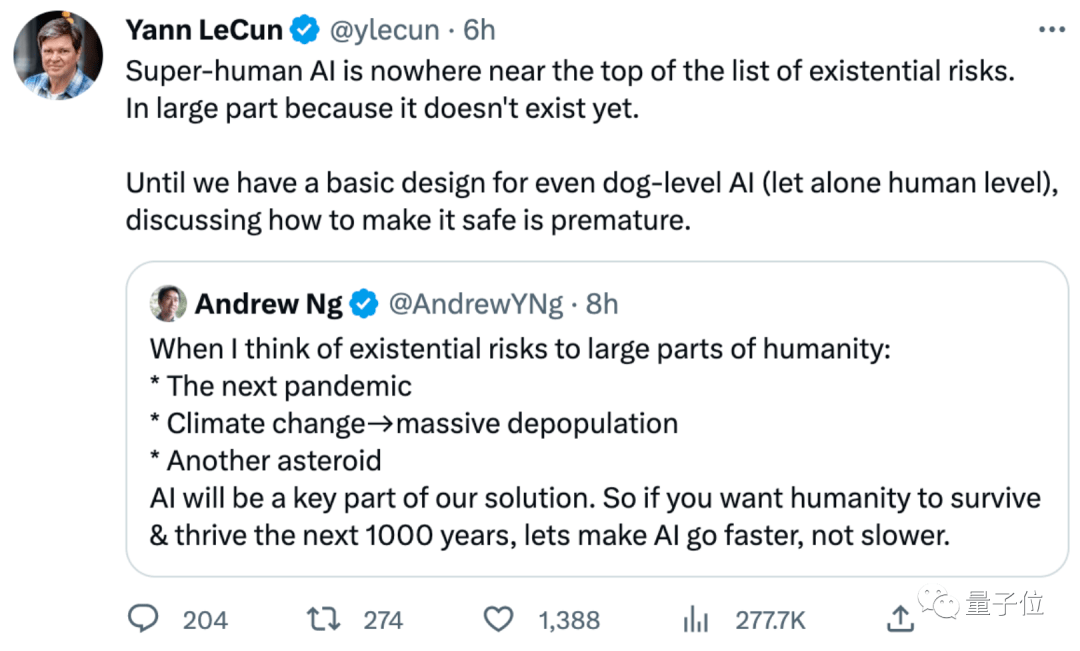

LeCun转发表示同意:

“超人级”AI之所以不在风险列表榜首,很大程度上是因为它还不存在。至少我们在设计出达到狗智商(更不用说人类了)的AI之前,讨论它的安全性还为时过早。

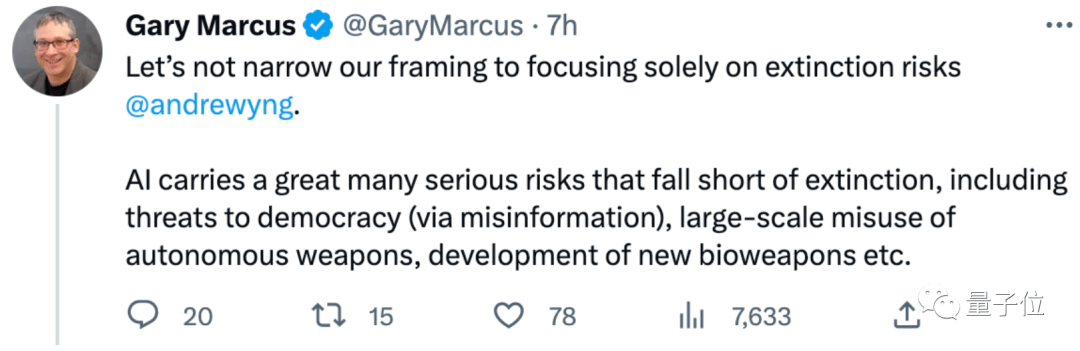

对此,纽约大学教授 Gary Marcus补充道:

不要把框架缩小到只关注人类灭绝的风险。AI其实还存在许多其他的严重风险,包括可能帮助开发生物武器等。

不过,Gary Marcus同样没有签署这份350人公开信。

显然包括不少AI大牛在内,反对者主要有两种意见。

一种意见认为,AI技术确实存在风险,但这封公开信涉及到的内容太泛泛。

如果有更精确的声明如“减轻AI技术的潜在风险应该是科技行业、政府和该领域学术研究人员的首要任务”,那么这封信还是可以签署的。

这封公开信中的内容根本就是夸大其词了,而且AI在气候变化等领域甚至可以起到降低风险的作用。

另一类意见则认为,这封信只不过是当前掌握最领先AI技术的人,试图控制AI接下来的走向而已。

以OpenAI的CEO Sam Altman为例:

Sam Altman要是真的担心,大可以现在直接关掉ChatGPT服务器。

所以,你认为按照现在的进度来看,AI有可能灭绝人类吗?

— 完—

「量子位·视点」直播报名

传统教育模式在信息时代遇到了怎样的限制与挑战?元宇宙、AIGC等新技术将如何开拓教培行业的新机遇?

6月1日周四19:00,参与直播,为你解答~

点这里 ?关注我,记得标星哦~

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见 ~ 返回搜狐,查看更多

责任编辑:

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!