文章主题:走进云栖大会2023, 云计算, 阿里云, 技术研发

走进云栖大会2023,不少云计算从业者也许会恍惚,仿佛坐上了时光机来到数年前。

在云栖小镇,你可以感受到阿里云创立早期的气息,那里充满了浓厚的科技氛围。无处不在的“计算,为了无法计算的价值”的标语,见证了阿里云从起步到发展的历程,直至今日仍回响在会议现场各个角落。这曾是阿里云初生的口号,直到七年前才得以更新。走进算力馆的大门,你会立刻被那醒目的巨大字体所吸引——“数据中心成为一台计算机”。这也正是阿里云最早的愿景之一,反映了其对技术驱动未来的坚定信念。

△云栖大会现场,36氪拍摄

阿里云声称其行为并非有意识地为之,然而各种线索汇集在一起,明确地向外界传达了一个信息:阿里云正在重新调整其战略方向,将重心重新放在技术研发上。

阿里云并没有让大模型成为2023年云栖大会的主角,不过,大模型却又无处不在。

做AI时代的“电动机”

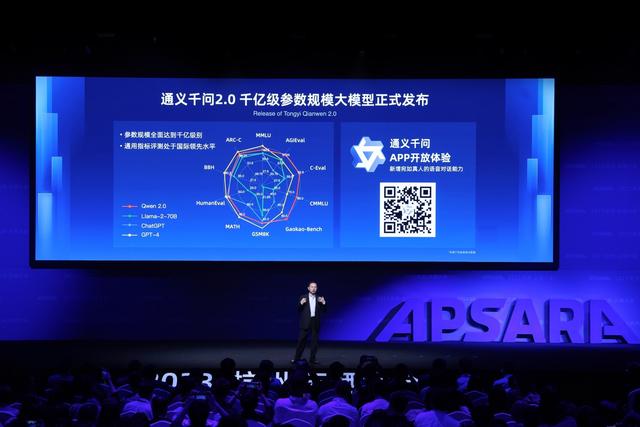

在今年四月份首次露面的通义千问,作为阿里巴巴云计算部门自主研发的底层通用大型语言模型,已经过去了半年的时间。现在,阿里巴巴云计算部门正式推出了通义千问的2.0版本,其参数数量已经达到了千亿级别。在各种评测中,该模型的综合性能已经超过了GPT-3.5,并且正在迅速接近GPT-4的水平。

通义千问2.0的参数表现出了在复杂指令理解、文学创作、通用数学、知识记忆以及幻觉抵御等多个领域上的明显进步。这直接反映在使用体验上,无论是从使用的便捷性还是效率来看,都展现出了更为成熟且实用的特点。

周靖人在谈论各种参数进展以及各类评测集上的分数时,只是简单地略过了。然而,他却在文章中花费了大量的篇幅,详细介绍了阿里巴巴在底层数据库、容器、模型开发平台以及开源社区等方面所取得的进步。

△来源:阿里云

一个关键因素是,大型模型已经流行了一年多,尽管在本质上它仍然是一个新兴事物。这些模型的显著突破很大程度上源于大规模的计算,许多训练都在云端进行。然而,现有的计算基础设施能力尚无法满足大型模型所需的计算需求。

“云计算和GPT的关系,就是电和电动机的关系。”阿里云创始人王坚如此表示。

在一次访谈中,周靖人透露,阿里云在初期尝试将数百台(GPU)服务器连接起来进行大规模训练时,面临着诸多困难。然而,随着技术的不断优化,大型模型的研发才得以逐步展开。然而,当模型发展至一定阶段,又出现了新的挑战,此时,阿里云便需要再次投入资源,进行服务器升级。

正因如此,阿里云这几年都在强调要回归基础计算技术,从底层芯片、数据库、中间件、开发平台都投入了不少人力物力去突破。而大模型如今还在从0到1的创新阶段,底层计算技术突破所带来的意义更甚。

比如,阿里云的PAI(人工智能平台)是训练AI模型的重要工具,通义千问就是基于这一平台训练而来。在本届云栖上,PAI的集群网络架构进行了全新升级,目前支持高达10万卡量级的训练集群规模,超大规模分布式训练加速比高达96%,可节省超过50%的算力资源。

所有这些进展,都会化为未来的AI算力基础设施基础,而大模型也只是未来AI服务的一个重要载体。

要落地产业,先团结开发者

2023年云栖的另一个关键词,是“开放”。

阿里巴巴集团董事会主席蔡崇信在主论坛演讲中重点提及的两个数据是:目前中国80%的科技企业,一半的大模型公司都跑在阿里云之上。以及,AI开源社区魔搭集聚了270万开发者,2300多个模型,模型下载量超过1亿。

和不少大模型厂商重点宣传B端落地不同,阿里云在云栖上重点向另一个群体——开发者发出讯号。“我们要做AI时代最开放的云。”蔡崇信表示。

△来源:阿里云

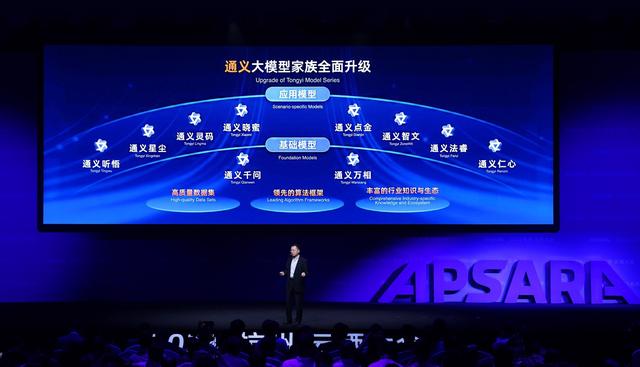

除了各项云计算的重要技术发布,阿里云今年还推出了“八大产品模型”,分别为:

值得注意的是,阿里云先推“产品模型”而非“行业模型”,显示出其战略的不同。阿里云更希望的是,提供底层的芯片、中间件、开发平台到上层的开源模型,然后让开发者、AI初创企业来集成、做应用,在各个行业里落地。

周靖人强调,阿里云推八大产品模型,并非为了直接To C提供服务,而是To B。这更多是像个面向客户的Demo,让客户先了解到大模型能做什么。

“要做最开放的一朵云,我们说到做到。这些应用模型我们都会开放API,欢迎开发者将上述的模型能力集成到自己的大模型应用和服务中。”他表示。

要把开发者团结起来,这是如今大模型落地的必选项——开发者的含义也变得更广泛,不只是行业集成商、AI初创,更多AI独立的开发者,也都是阿里云如今希望覆盖到的群体。

不过,36氪走访会场发现,云栖大会的人工智能展区中,参会的大模型厂商更多还是宣传自身的技术突破和进展。在各个行业中真正落地的案例还是偏少数。

有参会的大模型厂商告诉36氪,目前To B的项目大部分都还正在试点中,央国企的财政预算都是今年年底开始做计划,起码要到明年中旬,才会有比较多的落地实践。

大模型要在B端的生产环节中真正应用起来,还有很长一段的距离。

时灵时不灵,是当前大模型落地最大的障碍。据API Bank统计,即使是简单调用API,如今GPT-3.5的调用成功率也只在55%——对很多企业的生产环境而言,是无法接受的。上一波以人脸识别为主的AI浪潮,成功率基本要到95%以上才能真正可用;到最严格的自动驾驶场景,成功率更是需要达到99.9999999%(小数点后7个9),也就是说,几乎不能出错。

单纯靠大模型厂商来解决技术难题、做行业化落地并不现实。把开发者团结起来,一起突破工程化上的难题,这能加速大模型落地的实践。

对此,阿里云也实打实地放出了不少技术和产品支持,给开发者不仅提供“厨具”,也提供做饭原料。

此前,阿里云已先后开源7B和14B版本模型,周靖人表示,接下来的11月,阿里云还将开源720亿参数版本的通义千问大模型——这已经是一个能在大部分B端场景中进行商用的参数量级。

而从算力到开发工具,阿里云也有值得关注的产品,新推出的大模型应用开发平台“百炼”,就集成了国内外主流的优质大模型,为用户简化了底层算力部署、模型预训练、部署等环节。在算力层,“云工开物”还给中国4000多万高校学生每人送一台价值300元的云服务器,可以满足不少基础编程场景。

某种程度上,这和阿里云这几年重点讲的“被集成”战略一脉相承。经历了移动互联网浪潮而腾飞,阿里云如今仍是年收破千亿、国内第一的云厂商。但在全球云市场都还在苦苦应对增长放缓的背景下,云厂商想要吃到大模型带来的红利,还需耐心等待。

开放和团结,是当下最好的答案。

走进云栖大会2023, 云计算, 阿里云, 技术研发

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!