ChatGPT原理PDF:挖掘ChatGPT底层原理,理解实现方法

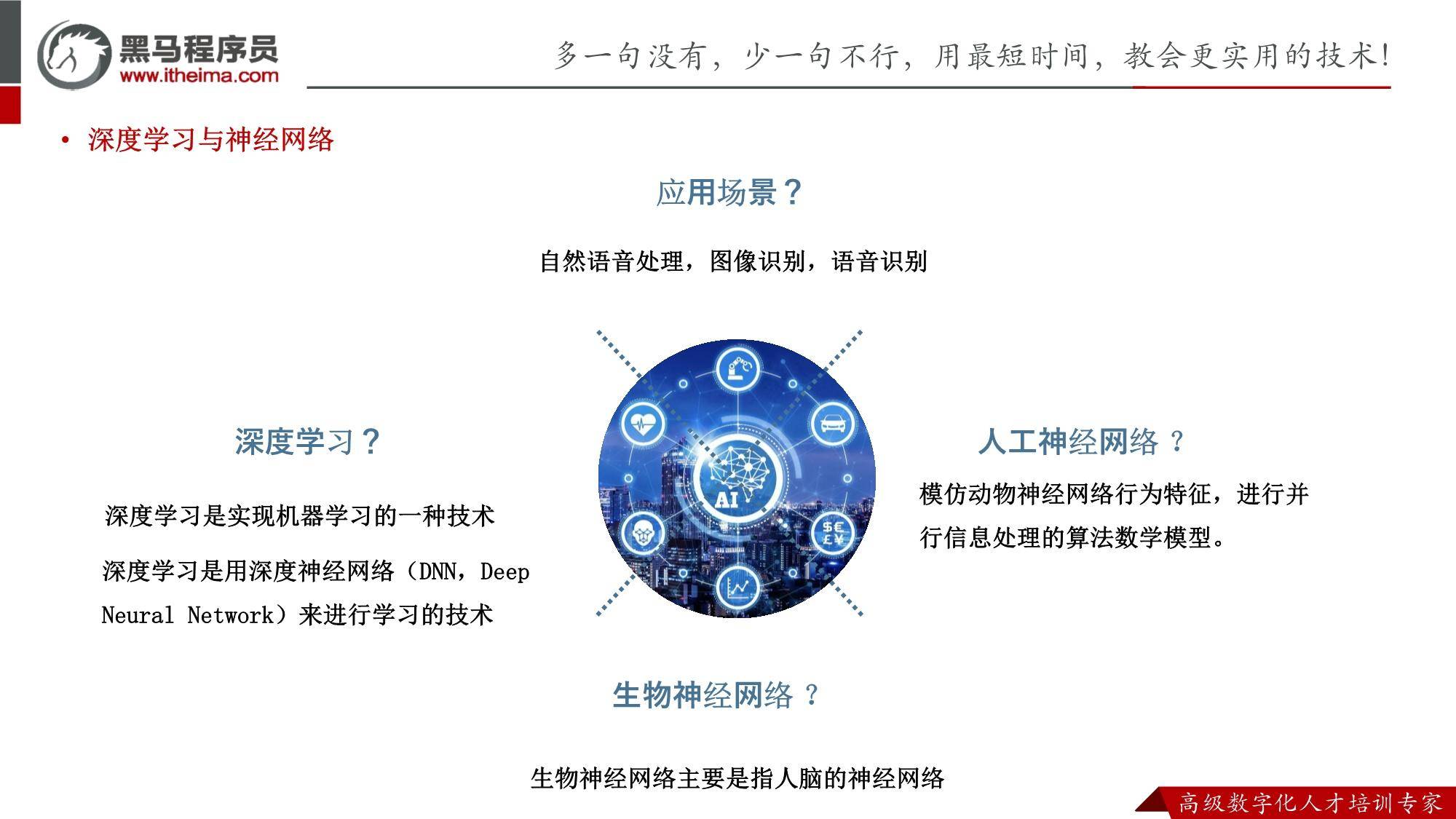

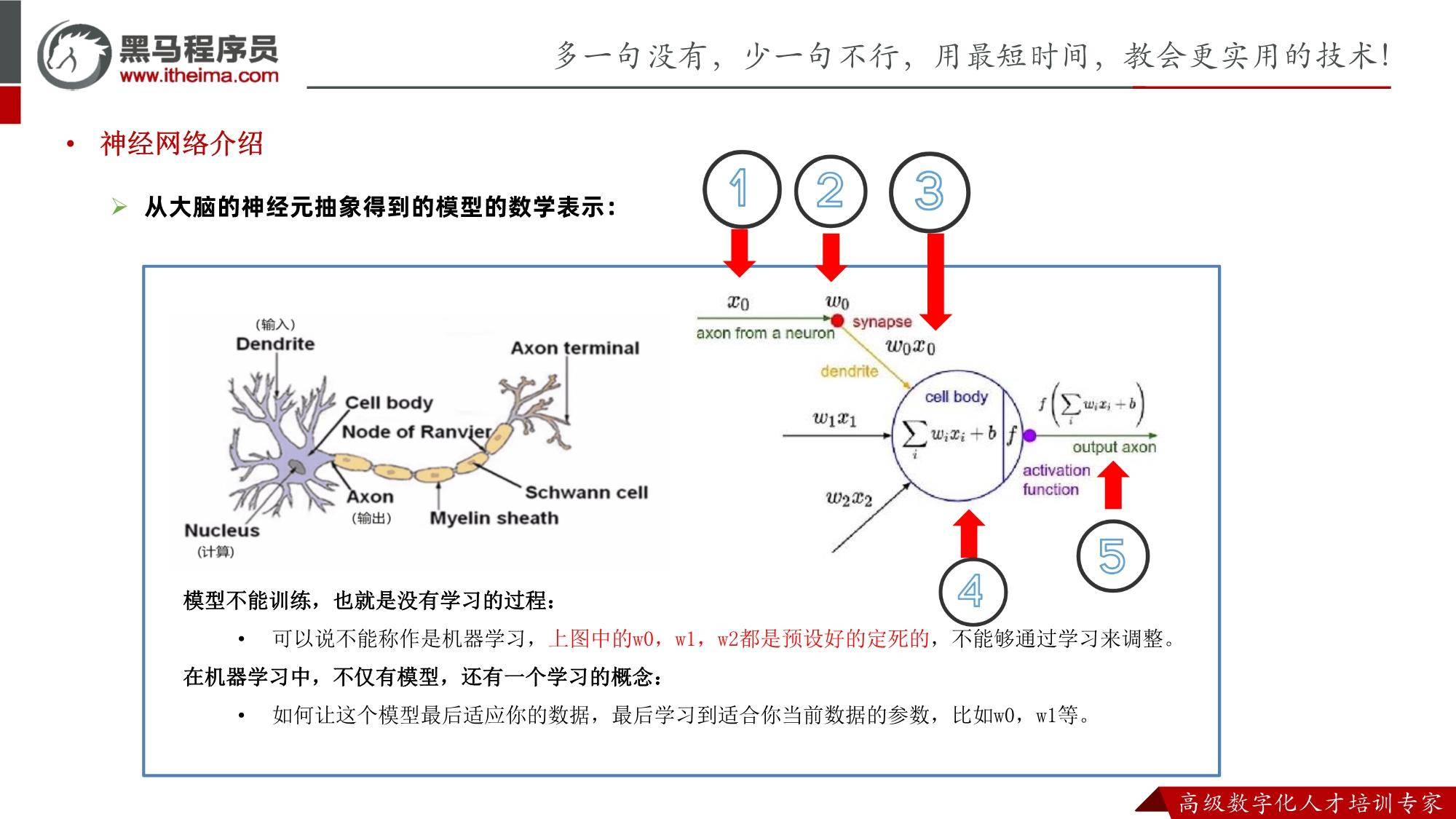

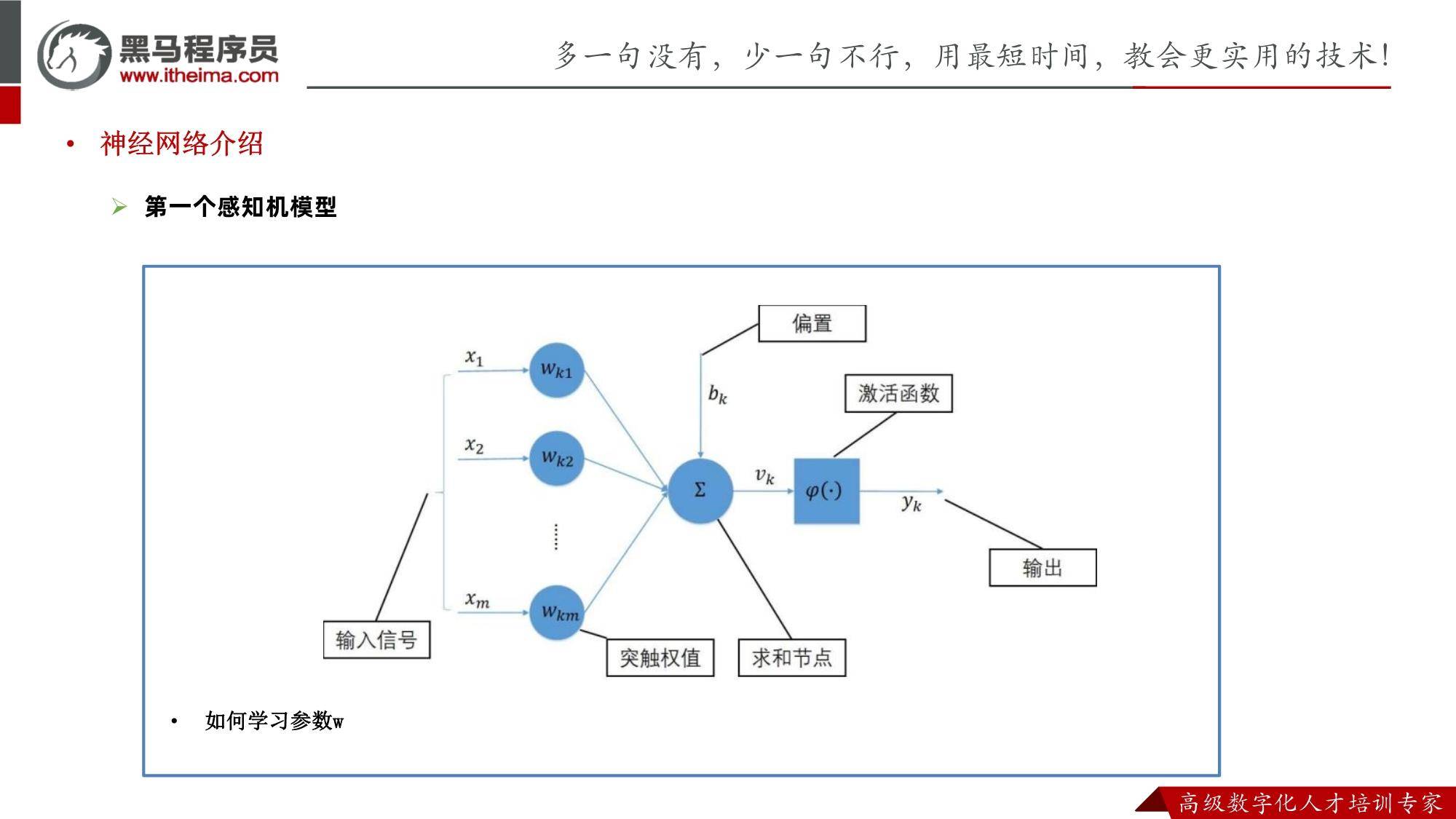

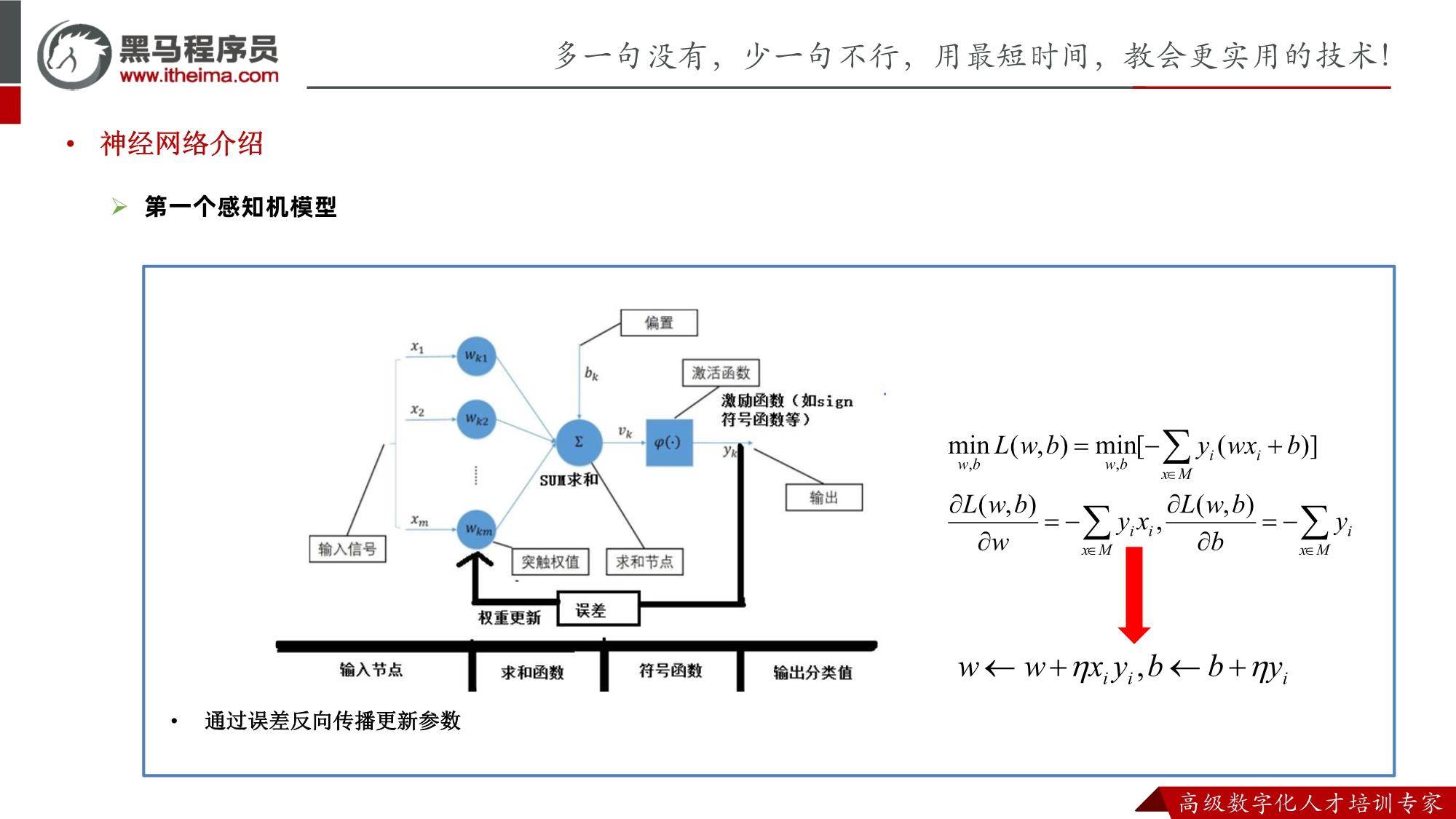

ChatGPT是一种基于人工智能的自然语言处理模型,由OpenAI提出并开发,该模型采用神经网络技术,并以Transformer网络结构为核心。它通过运用大量的语料库进行有监督训练,利用反向传播算法不断优化模型参数,从而使其具备了根据输入文本生成相应输出文本的能力。

ChatGPT的实现原理非常复杂,下面我们将详细介绍它的具体实现方式。

作为一款文章写作高手,我会将原文进行重新组织,使其表达更为精准和专业。在ChatGPT中,其采用了一种分层表示的方法,把输入的文本划分为多个层次,每个层次代表不同的语义信息。这种策略让ChatGPT更擅长处理自然语言的复杂性,并在生成文本时,能更精确地把握上下文的语境。这种分层表示策略,也被称为“自注意力机制”,它允许ChatGPT对输入序列中每一个位置进行编码,进而使模型能有效理解序列中各个位置间的关联。

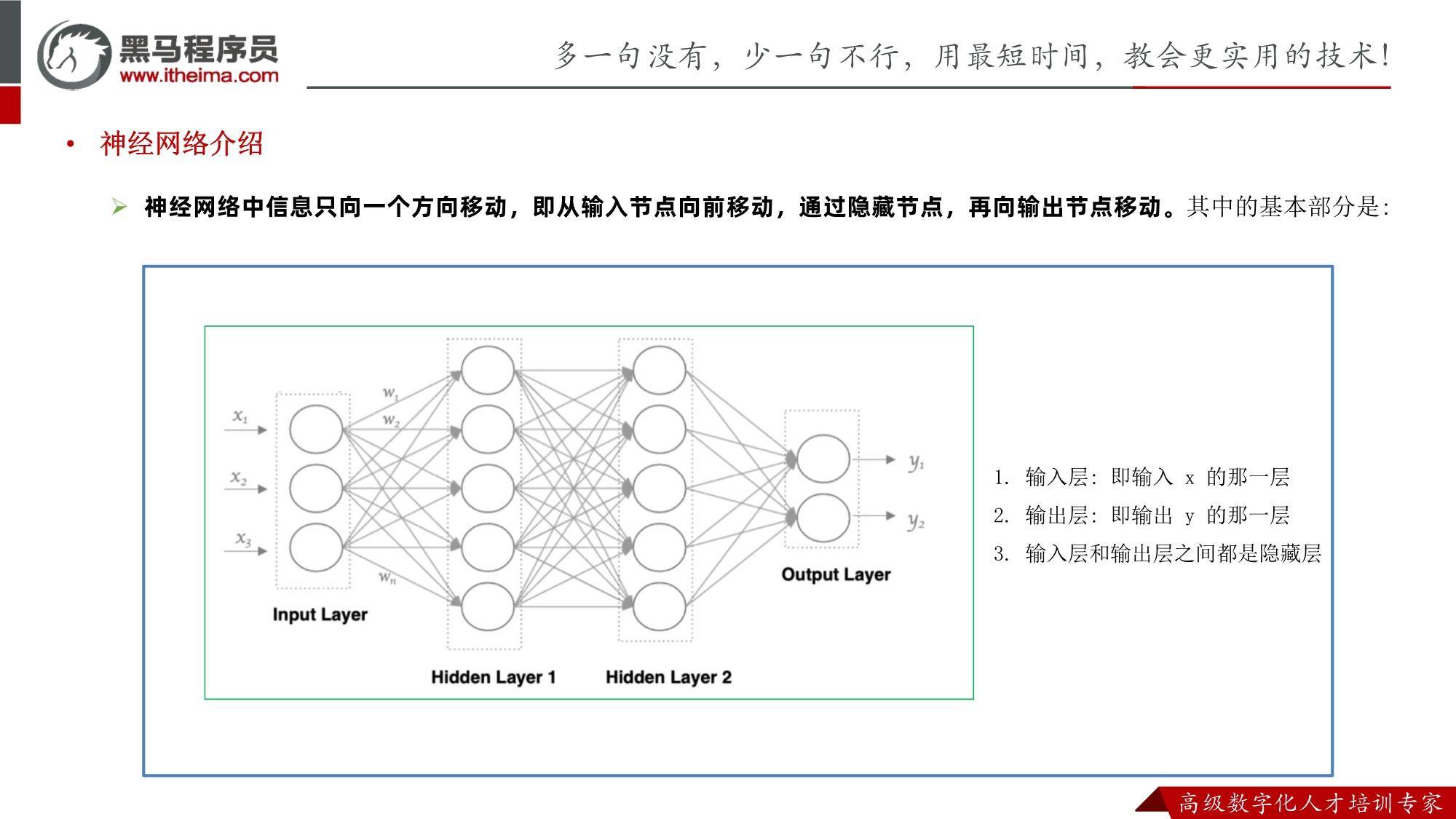

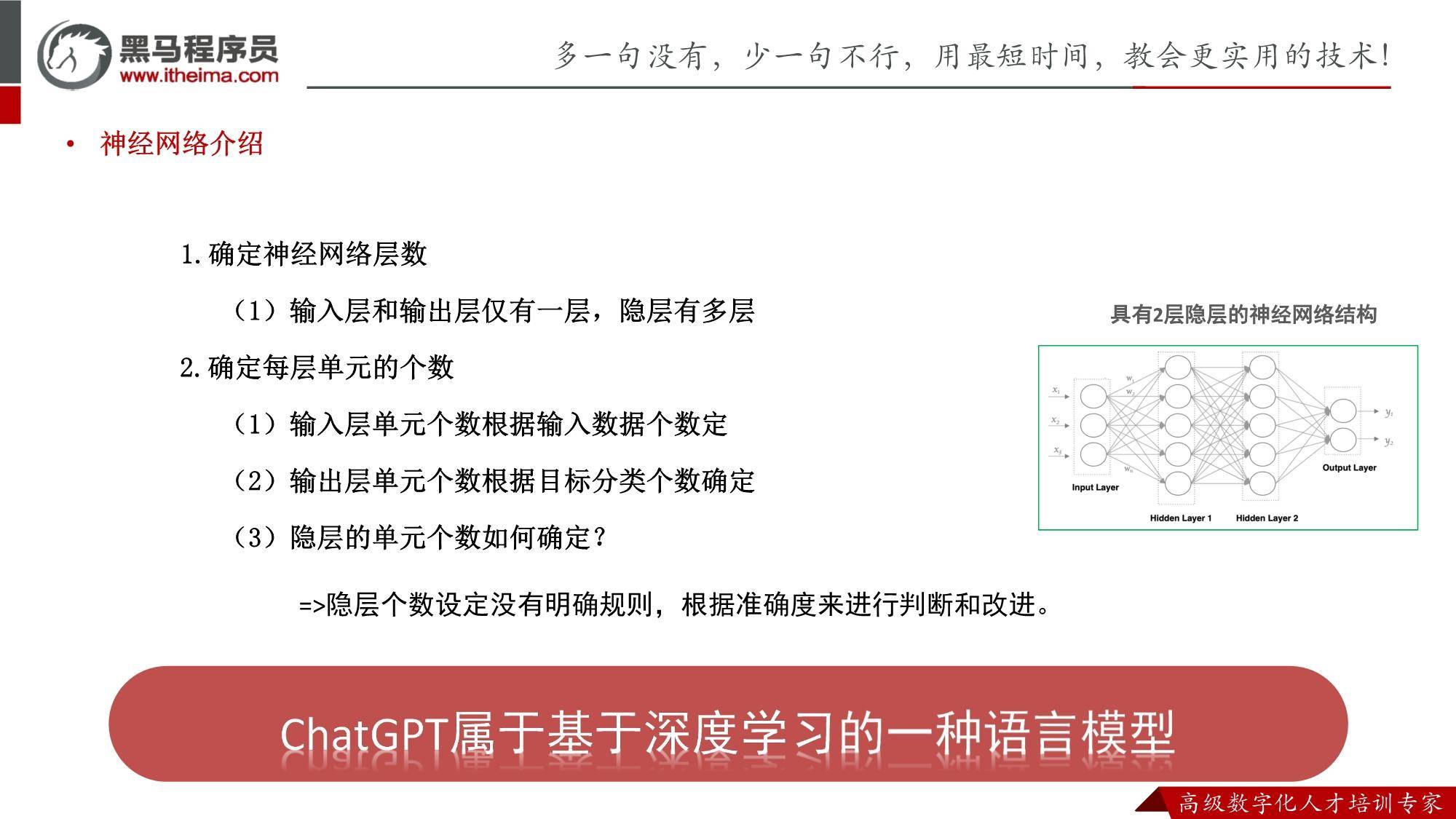

接下来,我们来探讨一下ChatGPT所使用的Transformer网络结构。Transformer是一种具有自注意力机制的序列到序列模型,其在自然语言处理领域中表现优异。这种网络结构的关键在于其自注意力机制,这一机制能让模型在计算每个位置的表示时,充分考虑其他所有位置的信息。这样的设计使得模型能更精准地理解文本中的上下文关联,并能够捕捉到文本中的长期依赖关系。在ChatGPT中,每一层的编码器都配备了自注意力机制和全连接前馈神经网络,这些编码器层共同构成了ChatGPT的基本架构。

接下来,我们探讨一下ChatGPT的训练方法。ChatGPT采用了预训练与微调相结合的方式进行训练,旨在提升模型的表现力。预训练的过程主要依赖大规模语料库进行无监督学习,让模型吸收丰富的语言知识。在预训练阶段,ChatGPT主要通过两个任务进行训练:掩码语言模型(MLM)和下一句预测(NSP)。掩码语言模型的训练方式是在文本中随机遮盖部分单词,要求模型根据上下文预测这些被遮盖的单词,从而增强模型对上下文的理解能力。而下一句预测则是判断两个句子是否属于同一个对话,模型会在此任务上进行有监督学习,进一步提升其性能。例如,可以在对话生成或文本分类等特定任务上对模型进行微调,使其在相应领域能更精确地生成语言或执行分类任务。

作为一款人工智能助手,ChatGPT的运作机制涉及数据处理与模型优化两个关键环节。在数据处理方面,ChatGPT运用了标记化技术,将原始文本转化为一系列标记或词向量,从而便于模型对其进行高效处理。而在模型优化方面,则采用了诸如Dropout、Layer Normalization等先进技术,旨在降低模型的过拟合风险,提升训练效率及表现。

ChatGPT是一种基于Transformer网络结构的人工智能助手,其实现原理涵盖了分层表示策略、预训练和微调方法、数据处理以及模型优化等多重维度。通过运用这些先进技术,ChatGPT具备了深度理解自然语言文本的能力,进而生成出高质量的自然语言文本。在自然语言处理领域,ChatGPT的应用场景极为广泛,包括但不限于对话生成、文本分类、语言翻译等。展望未来,随着ChatGPT技术的不断成熟和优化,我们有理由相信其在自然语言处理领域的应用将进一步拓展,为推动我国人工智能技术的发展发挥更大的作用。

来源:黑马程序员

报告内容节选如下:

资料下载方式:公众号《侠说》,www.guotaixia.com返回搜狐,查看更多

责任编辑:

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!