文章主题:中文通用大模型, SuperClue, 排行榜, 百度文心一言

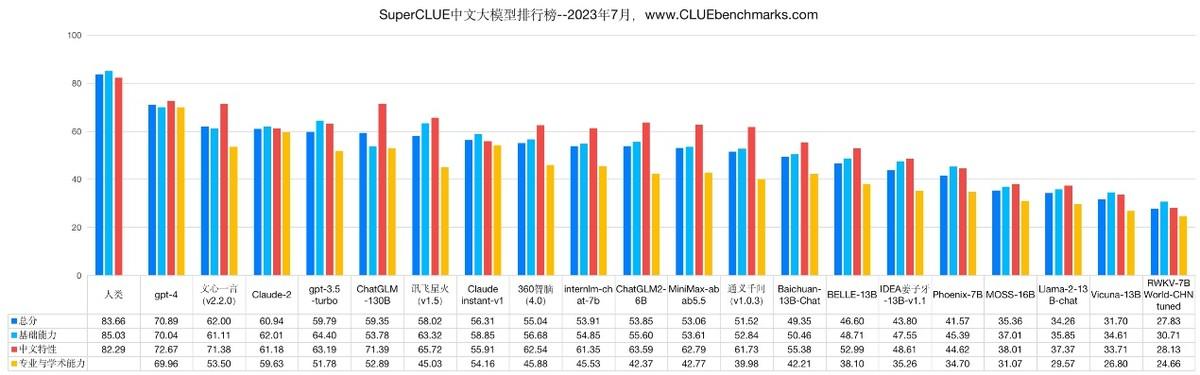

在7月25日发布的最新版中文大语言模型排行榜中,SuperClue基准显示了百度文心一言的总分超过了GPT-3.5-Turbo,成为我国大型语言模型的领军者。这一结果进一步证明了中国人工智能领域的实力与领导地位。

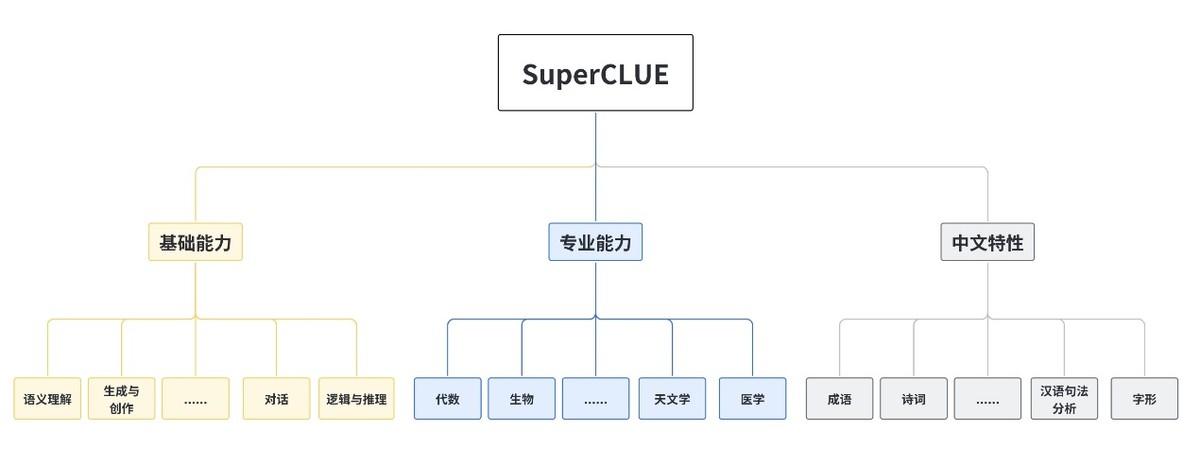

SuperCLUE-Opt评估标准作为SuperCLUE综合性三大基准之一,每期包含3700道客观题目(包括选择题)。这些题目分为三个主要部分:基础能力(共10个子任务)、中文特性能力(共10个子任务)以及学术专业能力(共50个子任务)。通过这些题目,我们可以全面评估大模型在超过70个任务中的综合性能。

在本次的SuperCLUE评测中,我们采用了基础能力、专业能力和中文特性能力这三个维度的70多项子能力指标,涵盖了国内外20个具有代表性的可应用的大模型进行评估。这样的设置旨在全面考核模型的综合能力,以及其在中文学务上的理解和积累。为了保证评测结果的公正性和客观性,我们还利用了自动化的测评方式,以一种相对客观的方式对各个模型的表现进行了评价。在总排名中,文心一言的表现紧随GPT-4之后,总分超过了GPT-3.5和其他我国的大模型,显示出其卓越的模型效果。

经过榜单的对比分析,我们发现尽管国外的GPT-4在效果上占据优势,但是我国的GPT模型也都有着出色的表现。特别是在中文领域,我国自主研发的大模型在某些方面有着突出的表现,逐渐缩小了与国际社会先进模型的差距。综合来看,我国的大模型中,百度文心一言的表现最为优秀。文心一言v2.2.0版依赖于的是文心大模型3.5,而文心大模型自2019年3月发布的1.0版以来,已经升级到了3.5版。这个新版本的模型在效果上提升了50%,训练速度提高了2倍,推理速度则提升了30倍。

据深入了解,本次评价的SuperClue大模型榜单是由我国发起的,被视为中文领域的权威评估平台。与国外UC伯克利LLM排行榜以及斯坦福AlpacaEval排行榜相比,SuperClue更倾向于纳入国内的大模型,从而使得其更适合国内用户进行横向对比。作为适用于中文的通用大模型评估标准,SuperCLUE通过多种角度的能力考核,对一系列国内外代表性的模型进行了评测。然而,由于其采用的是封闭式的问题设置,对于大模型来说,这无疑是一次“闭卷考试”,从而使得评估难度更大。

在评测基准中,我们的评估标准涵盖了基础能力和专业能力两个层面。其中,基础能力部分包括了十项具有代表性的模型能力,包括语义理解、对话、逻辑推理、角色扮演、代码、生成与创作等。这些能力能够全面考验机器在不同领域中的理解和应用能力。而在专业能力方面,我们则将目光投向了更为广泛的知识领域,覆盖了中学、大学以及专业考试所需的各种能力。具体来说,这包括数学、物理、地理等多个学科的知识,同时也涵盖了社会科学等更为广泛的领域。最后,在中文特性能力方面,我们关注的是中文语言的各个方面,包括成语、诗歌、文学、字形等,以期让机器更好地理解和应用中文语言。总的来说,我们的评测基准旨在全面评估机器在各方面的知识和能力。

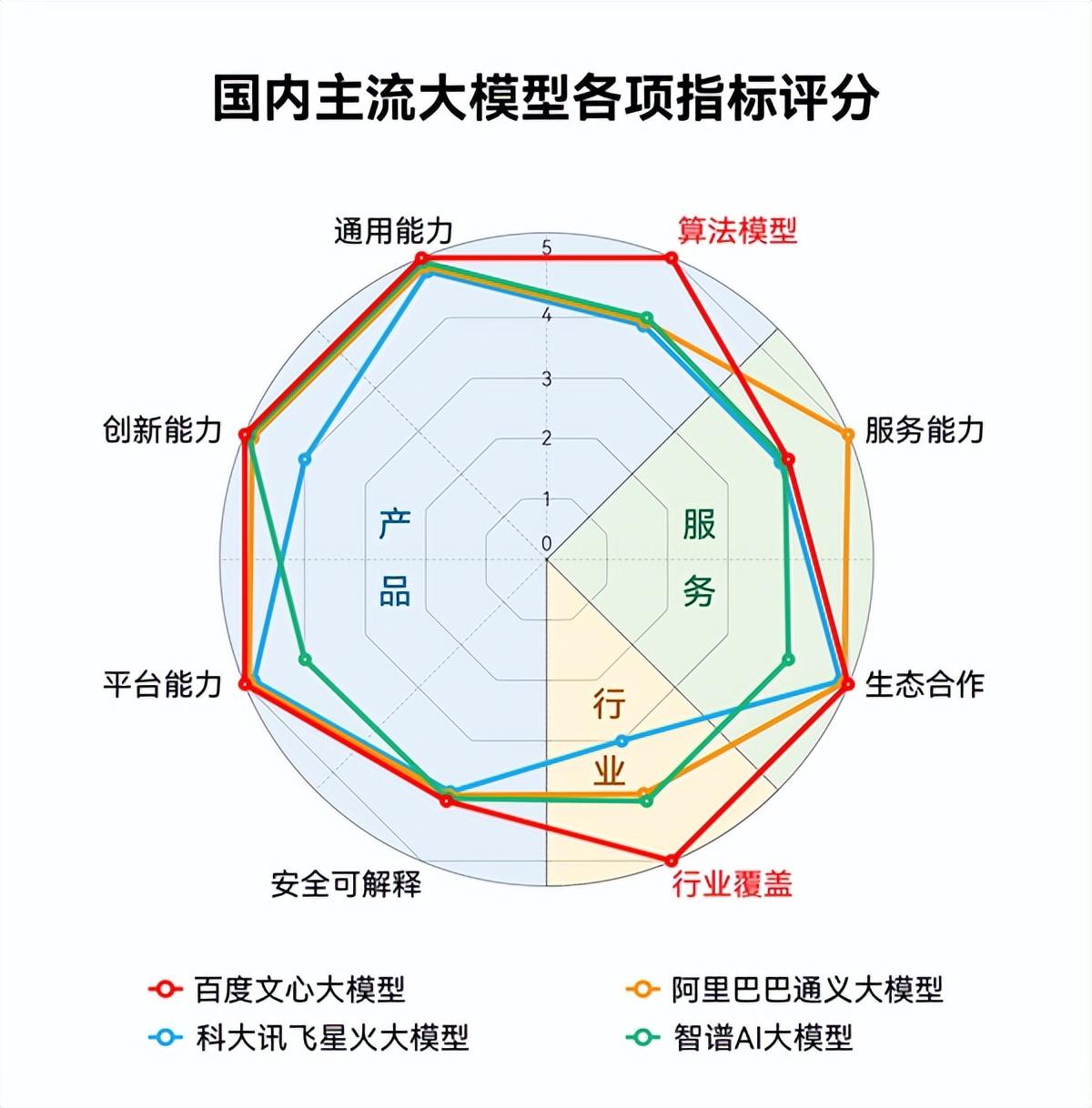

值得一提的是,全球领先的IT市场研究和咨询公司IDC最新发布《AI大模型技术能力评估报告,2023》显示,百度文心大模型3.5拿下12项指标的7个满分,综合评分第一,算法模型第一,行业覆盖第一,其中也是算法模型维度的唯一一个满分 。

另据近期多个公开测评显示,文心大模型3.5版支持下的文心一言中文能力突出,甚至有超出GPT-4的表现;综合能力在评测中超过ChatGPT,遥遥领先于其他大模型,稳居国内第一。

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!