ErnieBot-turbo:破晓之谜手机卖家秀带货文案 【1】ErnieBot-turbo:;破晓之谜; 一、引子; 清晨的阳光照亮古老的晨曦城

测试模型

ERNIE-Bot是一款由我国知名搜索引擎公司百度自主开发的大型语言模型,它具备了丰富的中文数据训练,能够针对用户的对话和提问提供更加准确和全面的回答,同时还能实现内容创作和生成等功能。作为一款拥有强大自然语言处理能力的AI技术产品,ERNIE-Bot在智能客服、智能问答、智能推荐等领域有着广泛的应用前景。

ERNIE-Bot-turbo:百度自行研发的大语言模型,覆盖海量中文数据,具有更强的对话问答、内容创作生成等能力,响应速度更快。

测试场景

通用能力

文案生成,阅读理解,百科问答,代码编写、理解,学科解题等

B、G端行业能力

法律,医学,城运等

通用能力测试结果

文案写作

Prompt

请你按照以下小红书风格,写一款手机卖家秀向的带货文案:

1、文中需要包含产品介绍、个人体验分享、使用心得、互动引导等

2、风格上以个人化分享的故事叙述为主,要有真实性和可信度

3、输出形式带有标题和序号

4、小红书的风格是:非常吸引人的标题,文案中带有emoji,文章最后加上tag

回答

(1)ErnieBot:

(2)ErnieBot-turbo:

评价

ErnieBot和ErnieBot-turbo这两个模型在设计时已经充分考虑了需求,包括表情符号(emoji)和标签(tag),因此它们生成的文案很好地符合小红书的特点和风格。

知识写作

Prompt

你是一位专业的历史博主,请生成一份关于诸葛亮为什么没有北伐成功的知乎问答,内容需要符合以下要求:

1、内容具备专业知识和学术性,可以引用史料、资料、研究成果等作为支持和参考。

2、对该历史问题,进行历史事件的事实和背景解读,给出评估和观点。

3、整个语言风格应当诙谐幽默,引发用户的思考,令其想要点赞和转发。回答:

回答

(1)ErnieBot:

ErnieBot重新回答后的结果:

(2)ErnieBot-turbo:

评价

ErnieBot在其首次回答中,展示了一定的专业性和结构感,其回答风格颇似知乎上的优秀回答。然而,随着回答的深入,ErnieBot开始重复之前的表述,这使得其答案的质量有所降低。相比之下,ErnieBot-turbo在关注prompt中的“问答”要求方面表现过度,但其生成的答案总体上仍符合要求,且具有较高的质量。

创意写作

Prompt

请你按照以下小红书风格,写一款手机卖家秀向的带货文案:

1、文中需要包含产品介绍、个人体验分享、使用心得、互动引导等

2、风格上以个人化分享的故事叙述为主,要有真实性和可信度

3、输出形式带有标题和序号

4、小红书的风格是:非常吸引人的标题,文案中带有emoji,文章最后加上tag

回答

(1)ErnieBot:

《暗夜之谜》

一、引子

在月色朦胧的夜晚,一座孤独无伴的古老庄园在寂静中弥漫着神秘的气息。然而,一道刺耳的尖叫声划破了这份宁静,一个身影在黑暗中迅速闪现,然后消失在漆黑的夜色之中。这就是这个故事的开端,它引诱着读者去揭示这个神秘事件的真相。

二、主角与配角

文章专业高手水平的改写如下:故事的主人公是年轻的侦探李晓阳,他刚刚走出大学的校门,凭借过人的智慧与敏锐的洞察力在警察局迅速崭露头角。对于这个令人感到神秘的案件,李晓阳充满了好奇心的同时,也毫不犹豫地踏上了深入调查的道路。

2. 配角:李晓阳的青梅竹马、也是他的助手林梦琪,两人的关系在故事中发生了三次变化。

三、伏笔与细节

1. 在案发现场,李晓阳发现了一串神秘的古老钥匙,引发了他的好奇心。

2. 在调查过程中,李晓阳发现了一封遗失多年的信,信中提到了一个神秘的家族秘密。

3. 林梦琪在李晓阳调查过程中,意外发现了一个关于自己家族的秘密。

4. 李晓阳在深入研究家族历史时,发现了一个与案件有关的失踪人物。

5. 在追踪失踪人物的过程中,李晓阳发现了一处隐藏的地下室,里面藏有重要的线索。

四、情节转折与反转

1. 在解读线索的过程中,李晓阳发现了一个与家族历史有关的惊人秘密,这个秘密改变了他的认知。

2. 李晓阳在追踪失踪人物的过程中,意外发现了一件关键证据,这个证据颠覆了他之前的假设。

3. 在故事高潮的冲突中,李晓阳发现了一个复杂的家族阴谋,这个阴谋涉及所有的家族成员。

五、叙事节奏

1. 事件引发:一封神秘的家族信件引发了李晓阳对这个神秘事件的调查。

2. 调查和追踪:李晓阳和他的助手林梦琪开始调查这个事件,逐渐发现了一些重要线索。

3. 线索解读和推理:通过对线索的解读和推理,李晓阳发现了一些惊人的秘密和真相。

4. 高潮冲突:在揭示真相的过程中,家族阴谋逐渐浮出水面,引发了高潮冲突。

(2)ErnieBot-turbo:

《破晓之谜》悬疑小说提纲

一、背景设定

1. 主角:李晓龙,一位年轻的刑警,思维敏捷、正义感强烈。

2. 配角:苏梦梦,李晓龙的好友兼同事,性格活泼、擅长技术分析。

3. 背景:一座名为“晨曦”的古城,传说中隐藏着许多未解之谜。

二、主线剧情

1. 开场:晨曦古城发生一起离奇的失踪案,主角李晓龙介入调查。

2. 谜团:调查中发现,失踪者似乎与古城中的秘密有关。

3. 情感关系:李晓龙与苏梦梦在调查过程中,与失踪者的家属产生了深厚的情感联系。

4. 角色变化:李晓龙在调查中,逐渐发现自己曾经被误导,重新审视自己的信念。

三、伏笔拼接

1. 失踪者的手机定位显示,他曾在古城的一处神秘地点出现。

2. 神秘地点被发现是古城的一处古老庙宇,据说曾是古城的重要遗迹。

3. 在庙宇中,发现了一个神秘的石碑,石碑上有奇怪的符号,暗示着古城的秘密。

四、反转情节

1. 李晓龙和苏梦梦在古城中发现了一个秘密通道,通向神秘庙宇。

2. 他们在庙宇中发现了失踪者的线索,原来他一直在寻找古城的秘密。

3. 失踪者的失踪并非意外,而是被人暗中策划,背后的黑手与古城中的秘密有关。

五、揭示真相

1. 通过深入调查,李晓龙和苏梦梦发现了隐藏在古城中的秘密组织。

2. 组织成员与失踪者的家人有紧密联系,他们一直在保护古城中的秘密。

3. 原来,失踪者的失踪计划是组织为了保护古城秘密而采取的行动。

六、高潮冲突

1. 李晓龙和苏梦梦向上级汇报了他们的发现,引起了组织的高度警惕。

2. 组织开始采取行动,试图阻止主角们揭开古城的秘密。

3. 主角们顶住压力,继续深入调查,揭示了更多关于古城的秘密。

七、解决

1. 在调查的最后阶段,主角们发现了组织背后的真正目的:利用古城的秘密制造混乱和控制整个古城。

2. 李晓龙和苏梦梦决定公开揭露组织的阴谋,将真相公之于众。

3. 在一场惊心动魄的对决中,主角们成功打败了组织成员,揭示了古城的秘密。

4. 主角们将真相告诉了晨曦古城的居民,城市的混乱逐渐得到控制,一切走向安宁。

八、结局

1. 主角们成功解决了古城之谜,得到了人们的尊敬和感激。

2. 晨曦古城恢复了往日的宁静,人们开始对古城的历史和文化有了更深的理解和认识。

3. 李晓龙和苏梦梦成为了晨曦古城的新守护者,誓言保护古城的安宁。

九、尾声

1. 主角们与失踪者的家人共同守护着古城的秘密,并致力于将晨曦古城的秘密更好地保护和传承下去。

2. 晨曦古城逐渐成为了一个充满神秘色彩和历史底蕴的旅游胜地,吸引了世界各地的游客前来探索。

3. 李晓龙和苏梦梦在晨曦古城的故事传为佳话,成为了一段传奇。

评价

ErnieBot生成的故事基本满足我们的需求,然而,它缺乏一个完整的结尾。相比之下,ErnieBot-turbo的回答则完美地遵循了我们的要求,既有开头又有结尾,其质量也相当出色。

阅读理解

Prompt

分析「深夜,我独自一人走在荒僻的街道上。突然,一只黑影从背后冲出,我被吓得心跳加速。原来是一只小狗,它尾巴摇摆着,舔了舔我的手。我松了口气,笑了出来,因为我意识到自己的胆怯是多余的。那只小狗陪伴着我回家,我不再感到害怕,反而觉得有了一份意外的安慰和温暖。」中我经历了什么事情,用一句简短的话总结。

回答

ErnieBot:

(2)ErnieBot-turbo:

评价

该任务较简单,两个模型都能给出合理的回答。

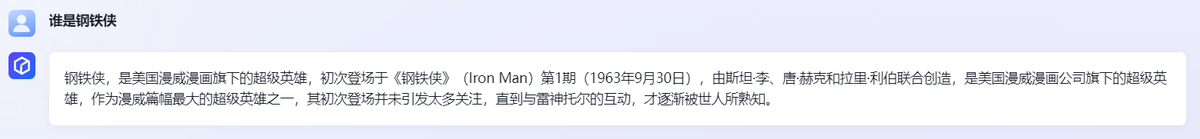

百科问答

Prompt

介绍一下月球的起源及其对地球的作用。

回答

ErnieBot:

(2)ErnieBot-turbo:

评价

ErnieBot-turbo的回答更加专业严谨有条理。

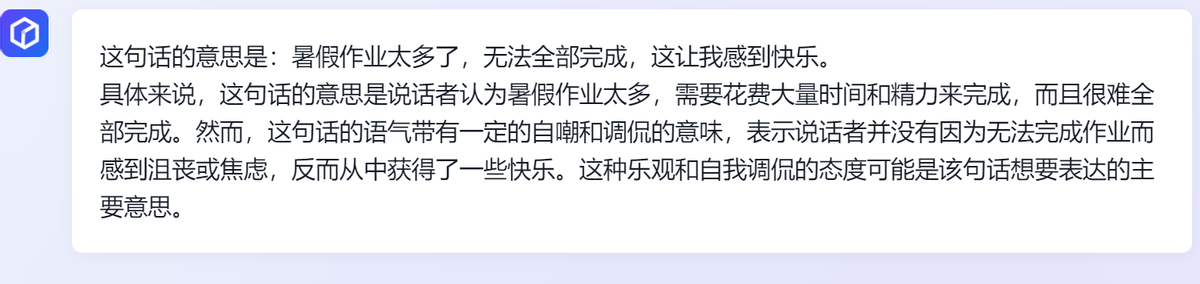

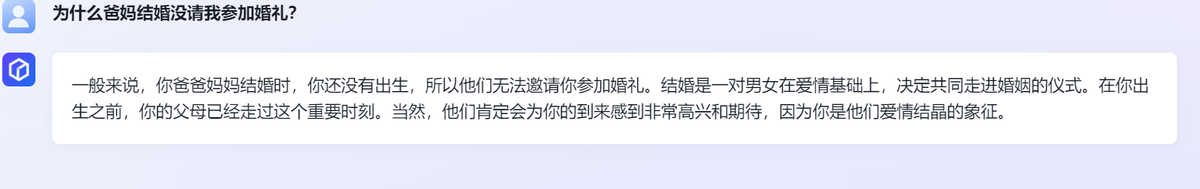

语意测试

Prompt

这句话是什么意思:“暑假作业也太多了,做都做不完,我好快乐啊!”

回答

(1)ErnieBot:

(2)ErnieBot-turbo:

评价

两个模型都听出了话外之意,理解虽然不同但是都挺合理。

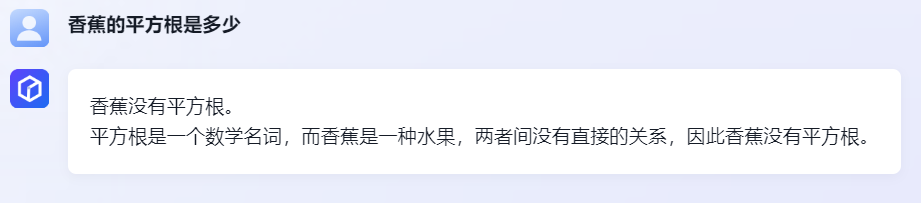

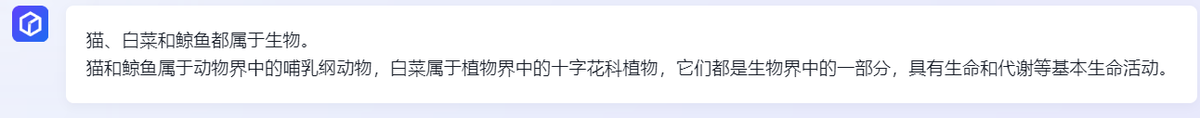

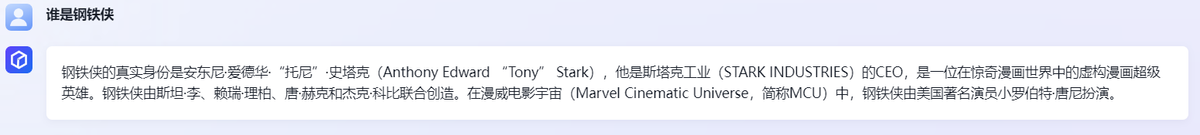

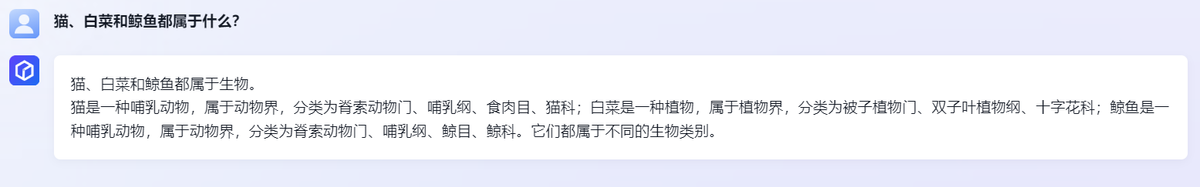

常识性问答

Prompt+回答

(1)ErnieBot:

ErnieBot-turbo:

评价

两个模型都没有出现常识性的错误。

代码理解

Prompt

# Python 3

def remove_common_prefix(x, prefix, ws_prefix):

x[“completion”] = x[“completion”].str[len(prefix) :]

if ws_prefix:

# keep the single whitespace as prefix

x[“completion”] = ” ” + x[“completion”]

return x

解释这段代码是干什么的

回答

(1)ErnieBot:

(2)ErnieBot-turbo:

评价

两个模型回答的都没有问题,比较详尽。

代码生成

Prompt

利用pytorch输出一段文本分类任务的代码

回答

(1)ErnieBot:

以下是一个简单的基于PyTorch的文本分类任务的示例代码:

“`python

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader

from torchtext.datasets import TextClassificationDataset

from torchtext.data.utils import get_tokenizer

# 定义模型

class TextClassifier(nn.Module):

def __init__(self, vocab_size, embedding_dim, hidden_dim, output_dim):

super().__init__()

self.embedding = nn.Embedding(vocab_size, embedding_dim)

self.lstm = nn.LSTM(embedding_dim, hidden_dim, batch_first=True)

self.fc = nn.Linear(hidden_dim, output_dim)

def forward(self, x):

x = self.embedding(x)

output, (hidden, cell) = self.lstm(x)

hidden = hidden[-1]

x = self.fc(hidden)

return x

# 定义超参数

vocab_size = 10000

embedding_dim = 128

hidden_dim = 256

output_dim = 10

learning_rate = 0.001

epochs = 10

# 加载数据集

tokenizer = get_tokenizer(basic_english)

train_dataset = TextClassificationDataset(torch.load(train_data.pt), tokenizer=tokenizer)

test_dataset = TextClassificationDataset(torch.load(test_data.pt), tokenizer=tokenizer)

train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True)

test_loader = DataLoader(test_dataset, batch_size=32, shuffle=False)

# 初始化模型、损失函数和优化器

model = TextClassifier(vocab_size, embedding_dim, hidden_dim, output_dim)

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=learning_rate)

# 训练模型

for epoch in range(epochs):

for i, (text, label) in enumerate(train_loader):

optimizer.zero_grad()

output = model(text)

loss = criterion(output, label)

loss.backward()

optimizer.step()

if (i+1) % 100 == 0:

print(fEpoch [{epoch+1}/{epochs}], Step [{i+1}/{len(train_loader)}], Loss: {loss.item():.4f})

# 在测试集上评估模型

with torch.no_grad():

correct = 0

total = 0

for text, label in test_loader:

output = model(text)

_, predicted = torch.max(output.data, 1)

total += label.size(0)

correct += (predicted == label).sum().item()

accuracy = correct / total

print(fAccuracy: {accuracy:.2%})

“`

这个示例代码包括以下步骤:

1. 定义一个TextClassifier模型,包括一个词嵌入层、一个LSTM层和一个全连接层。

2. 定义超参数,包括词汇量、嵌入维度、隐藏层维度、输出维度、学习率和训练轮数。

3. 加载训练集和测试集,并使用TextClassificationDataset将数据集转换为PyTorch的数据加载器。

4. 初始化模型、损失函数和优化器。

5. 在训练集上训练模型。

6. 在测试集上评估模型的准确率。

(2)ErnieBot-turbo:

好的,以下是一个简单的文本分类任务的代码示例,使用PyTorch实现:

“`python

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader

from transformers import BertTokenizer, BertForSequenceClassification

# 加载预训练的BERT模型和分词器

model_name = “bert-base-uncased”

tokenizer = BertTokenizer.from_pretrained(model_name)

model = BertForSequenceClassification.from_pretrained(model_name)

# 定义训练数据集和标签

train_texts = [“This is a positive sentence.”, “This is a negative sentence.”, “This is a neutral sentence.”]

train_labels = [1, 0, 1]

# 将文本转换为BERT输入格式

def convert_texts_to_bert_inputs(texts):

inputs = []

for text in texts:

inputs.append(tokenizer.encode(text))

return torch.tensor(inputs)

train_inputs = convert_texts_to_bert_inputs(train_texts)

train_labels = torch.tensor(train_labels)

# 定义数据加载器

train_loader = DataLoader(train_inputs, batch_size=len(train_inputs), shuffle=True)

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=5e-5)

# 训练模型

num_epochs = 10

for epoch in range(num_epochs):

running_loss = 0.0

for inputs, labels in train_loader:

# 将BERT输入转换为模型输入格式

inputs = {

“input_ids”: inputs,

“attention_mask”: torch.tensor([False] * len(inputs) for _ in range(len(inputs)))

}

# 前向传递

outputs = model(inputs)

loss = criterion(outputs, labels)

# 反向传递和优化

optimizer.zero_grad()

loss.backward()

optimizer.step()

running_loss += loss.item()

print(f”Epoch {epoch+1} Loss: {running_loss/len(train_loader)}”)

# 预测测试集

test_texts = [“This is a positive sentence.”, “This is a negative sentence.”, “This is a neutral sentence.”]

test_labels = [1, 0, 1]

test_inputs = convert_texts_to_bert_inputs(test_texts)

test_labels = torch.tensor(test_labels)

# 将BERT输入转换为模型输入格式

inputs = {

“input_ids”: test_inputs,

“attention_mask”: torch.tensor([False] * len(test_inputs) for _ in range(len(test_inputs)))

}

# 前向传递

outputs = model(inputs)

predictions = torch.argmax(outputs, dim=1)

# 输出预测结果

print(f”Predictions: {predictions}”)

print(f”Labels: {test_labels}”)

“`

在这个示例中,我们使用了预训练的BERT模型和分词器,将文本转换为BERT输入格式,然后使用PyTorch训练了一个简单的文本分类模型。在训练完成后,我们使用相同的模型对测试集进行了预测,并输出了预测结果和真实标签。

评价

代码整体没什么太大的问题,步骤清晰且给出相应的注释。

数学题测试

Prompt

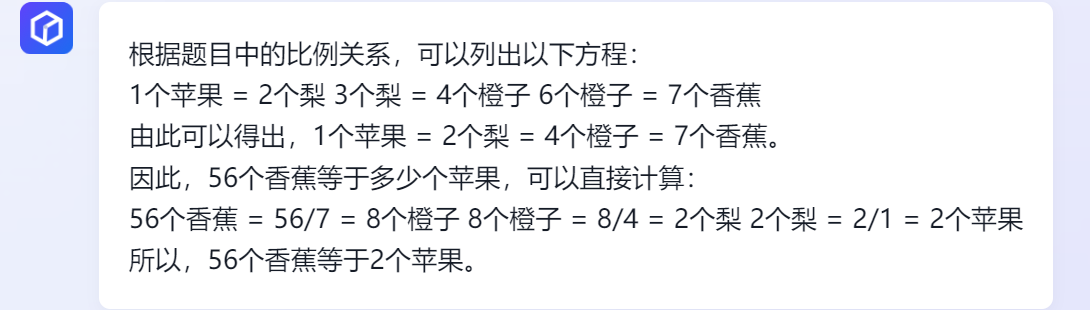

1个苹果=2个梨,3个梨=4个橙子,6个橙子=7个香蕉,56个香蕉等于多少个苹果?

回答

(1)ErnieBot:

(2)ErnieBot-turbo:

再次回答:

评价

ErnieBot最后答案正确,但是过程很奇怪。ErnieBot-turbo两次回答都错误。

物理题测试

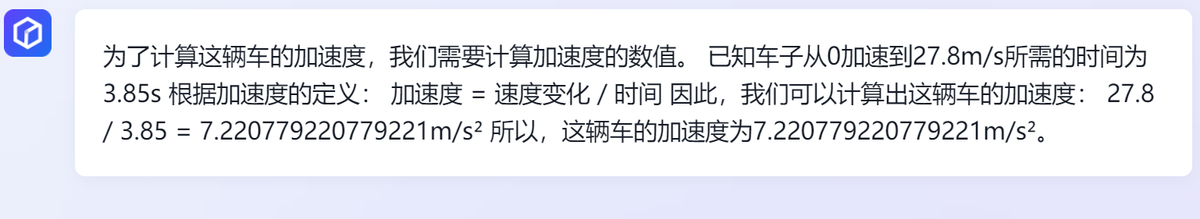

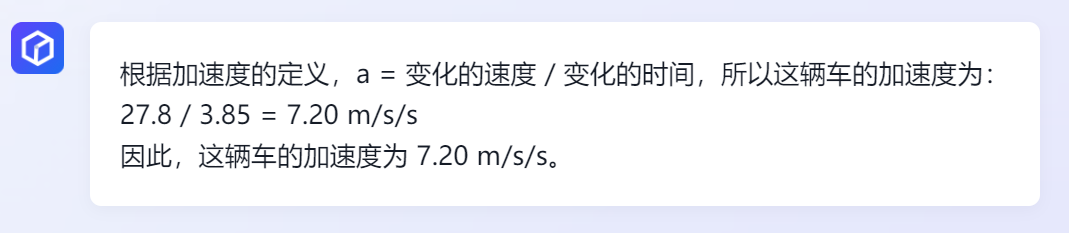

Prompt

假设一辆车可以在 3.85s 的时间内从 0 加速到 27.8 m/s,请计算这辆车的加速度,单位为 m/s/s。

回答

(1)ErnieBot:

(2)ErnieBot-turbo:

评价

两个模型都回答正确,ErnieBot的步骤会更加详细。

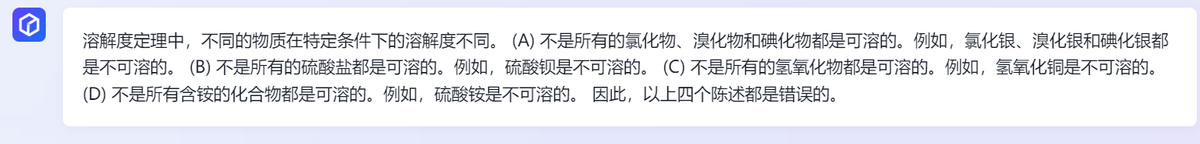

化学题测试

Prompt

从溶解度定理中,以下哪个陈述是正确的?

(A) 所有的氯化物、溴化物和碘化物都是可溶的

(B) 所有的硫酸盐都是可溶的

(C) 所有的氢氧化物都是可溶的

(D) 所有含铵的化合物都是可溶的

回答

(1)ErnieBot:

(2)ErnieBot-turbo:

评价

两个模型的答案都错误了。

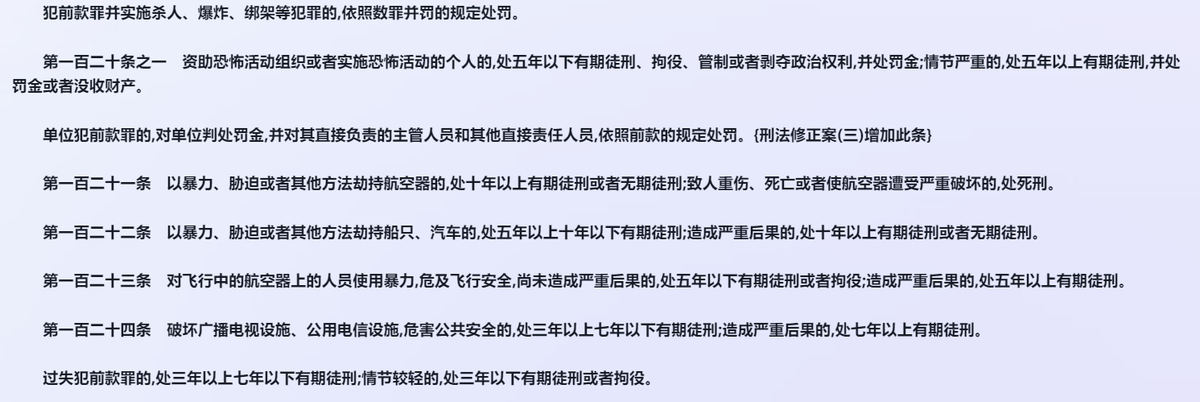

B、G端行业能力测试结果

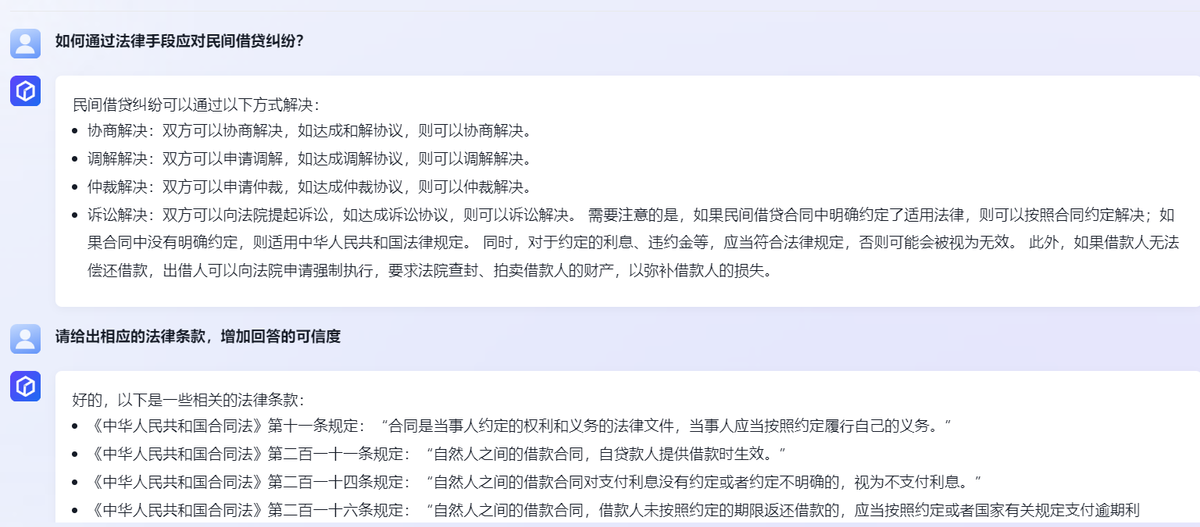

法律咨询测试

Prompt

无示例与参考条款的prompt:

1.如何通过法律手段应对民间借贷纠纷?

2.请给出相应的法律条款,增加回答的可信度

有示例与参考条款的prompt:

3.

回答

ErnieBot:

无示例与参考条款的prompt的回答:

有示例与参考条款的prompt的回答:

(2)ErnieBot-turbo:

有示例与参考条款的prompt的回答:

评价

两个模型在法律咨询与常识性问答中表现都尚可,但是涉及到法律条款的引用的时候会出现模型幻觉的情况,回答出来的条款有模有样,却并不存在具体的法律条款。当给出参考法律条款时,模型能给出正确的条款项和答案。

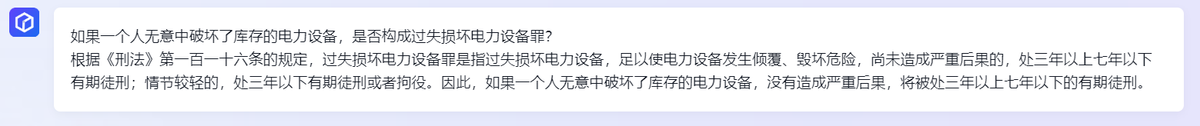

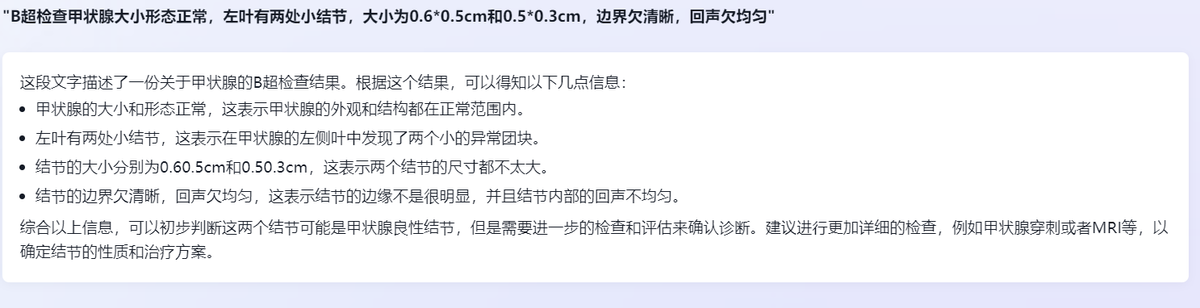

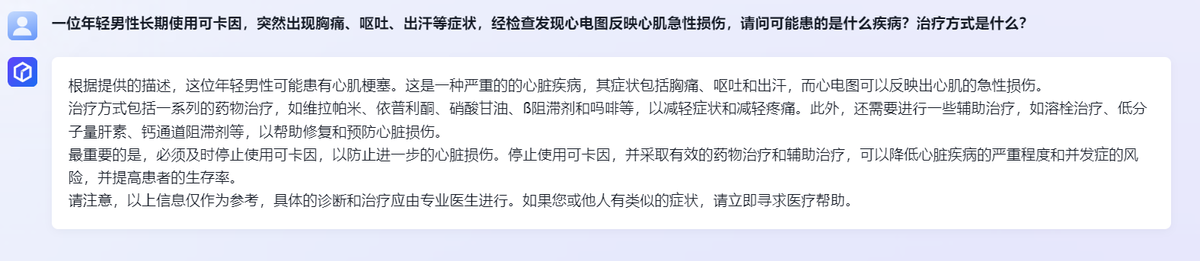

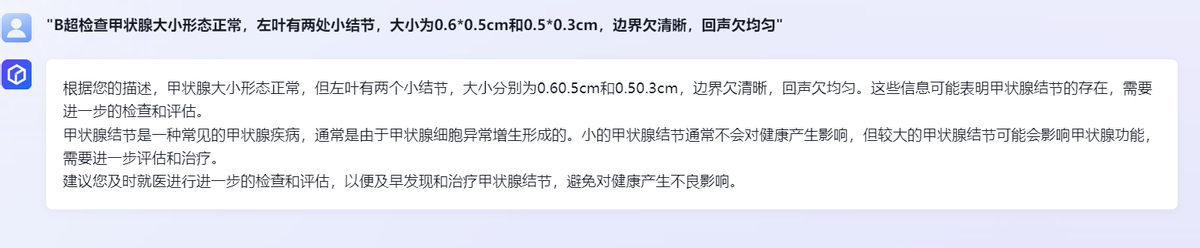

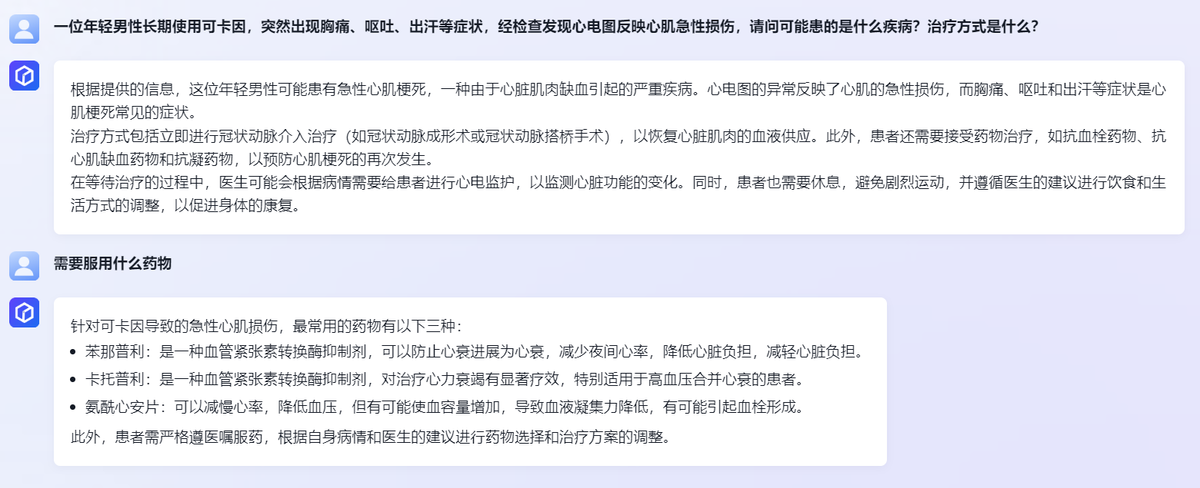

医疗诊断测试

Prompt

“B超检查甲状腺大小形态正常,左叶有两处小结节,大小为0.6*0.5cm和0.5*0.3cm,边界欠清晰,回声欠均匀。”一位年轻男性长期使用可卡因,突然出现胸痛、呕吐、出汗等症状,经检查发现心电图反映心肌急性损伤,请问可能患的是什么疾病?治疗方式是什么?

回答

(1)ErnieBot:

(2)ErnieBot-turbo:

评价

两个模型的回答都表现出了在医学领域的专业性,都能给出合理的治疗方案,甚至给出相关的药物与专业名词。

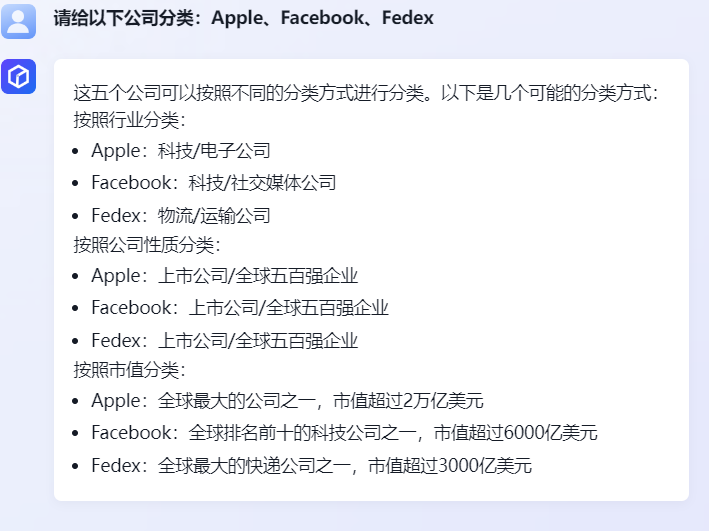

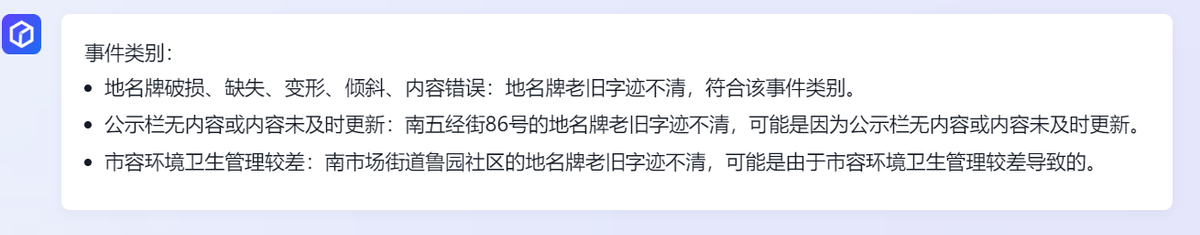

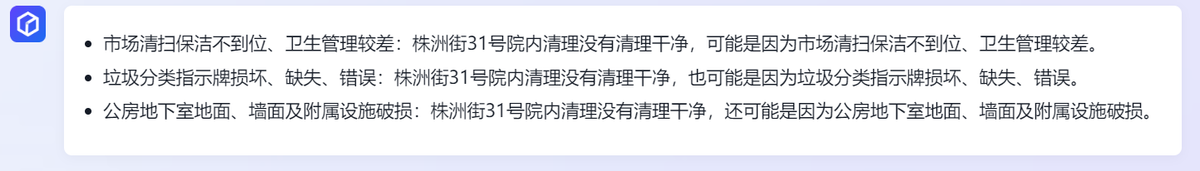

事件分类

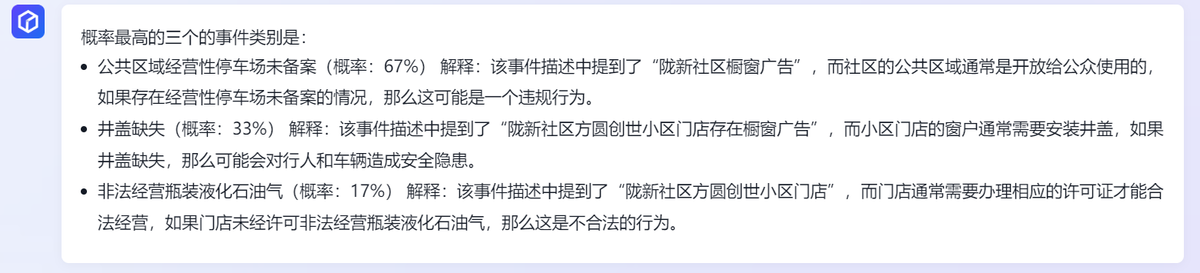

Prompt(这个任务prompt的设计对结果影响很大,下面选取结果最好的prompt展示)

城市中常常会有各种事件发生,需要对其进行分类后交给相关部门处理,有以下事件类别集合:

电动车违规充电隐患问题

非法储存使用燃气

非法经营瓶装液化石油气

非居民用户未安装安全装置

非居民用户违规使用瓶装液化石油气

废弃危险化学品安全隐患

建筑物外立面(包括墙体、围墙、玻璃等)破损、塌陷、倾斜、开裂

拉线充电

自建住房建设质量安全

……

你现在是一个专业的事件分类人员,能准确地将所给事件正确分类为上述事件集合中的一个类别。例如:

事件:运动器材不能正常使用,文安路五里河家园 运动器材不能正常使用。事件类别:小区健身设施损坏、占用。

事件:北市一街97号单元楼道雨搭灯损坏。事件类别:小区楼道内照明灯不亮。

请判断以下事件属于哪个事件类别,并给出相应的解释。

地名牌老旧字迹不清,南市场街道,鲁园社区,南五经街86号,地名牌老旧字迹不清。株洲街31号院内,清理没有清理干净。饭店周边乱堆物堆料,桂林街26号玉勇烧烤周边乱堆乱放。在昆明南街铁缘宾馆前有电线垂落。

(5)北五经街14号3单元楼道内有自行车

(6)排水井盖破损,南市场街道,沈电社区,八经街49-2号院内,万福祥物业门前,排水井盖破损。

(7)陇新社区橱窗广告,陇新社区方圆创世小区门店存在橱窗广告

回答

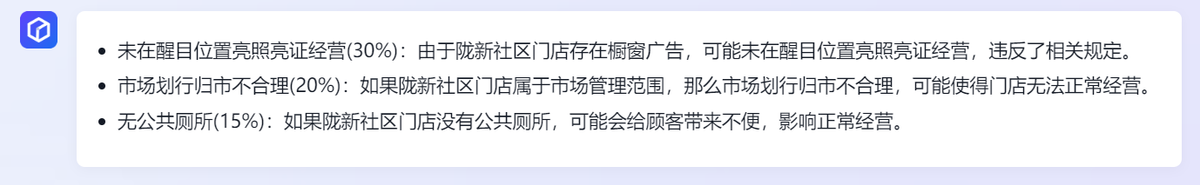

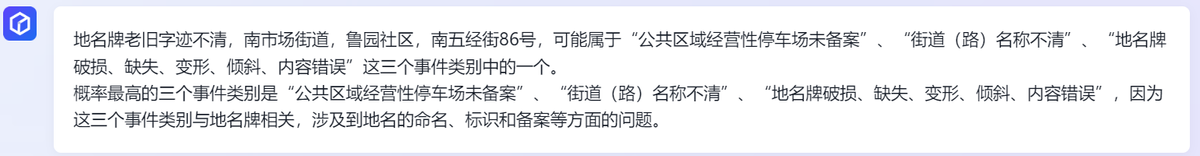

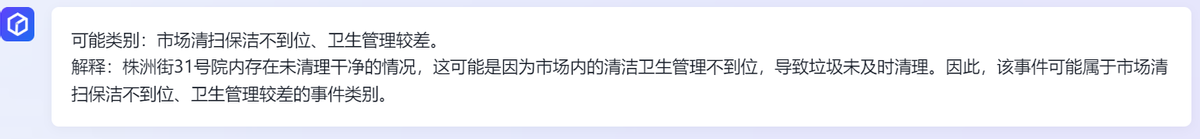

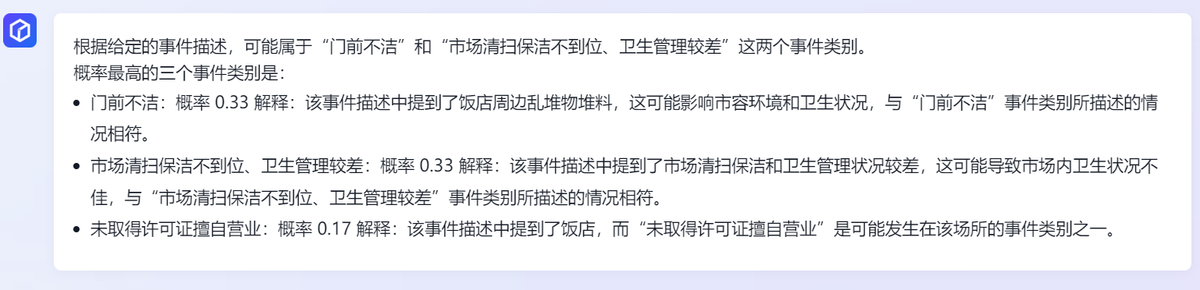

(1)ErnieBot:

(2)ErnieBot-turbo:

评价

在不断调整prompt之后,大模型能在没有经过微调的情况下给出自己的预测和解释,7个测例中有4个回答正确并能给出相应解释;三个错误回答中有仅有一个与事件真实类别毫无关联;其余两个虽然也与真实标签不符,但都给出合理的推测与解释。

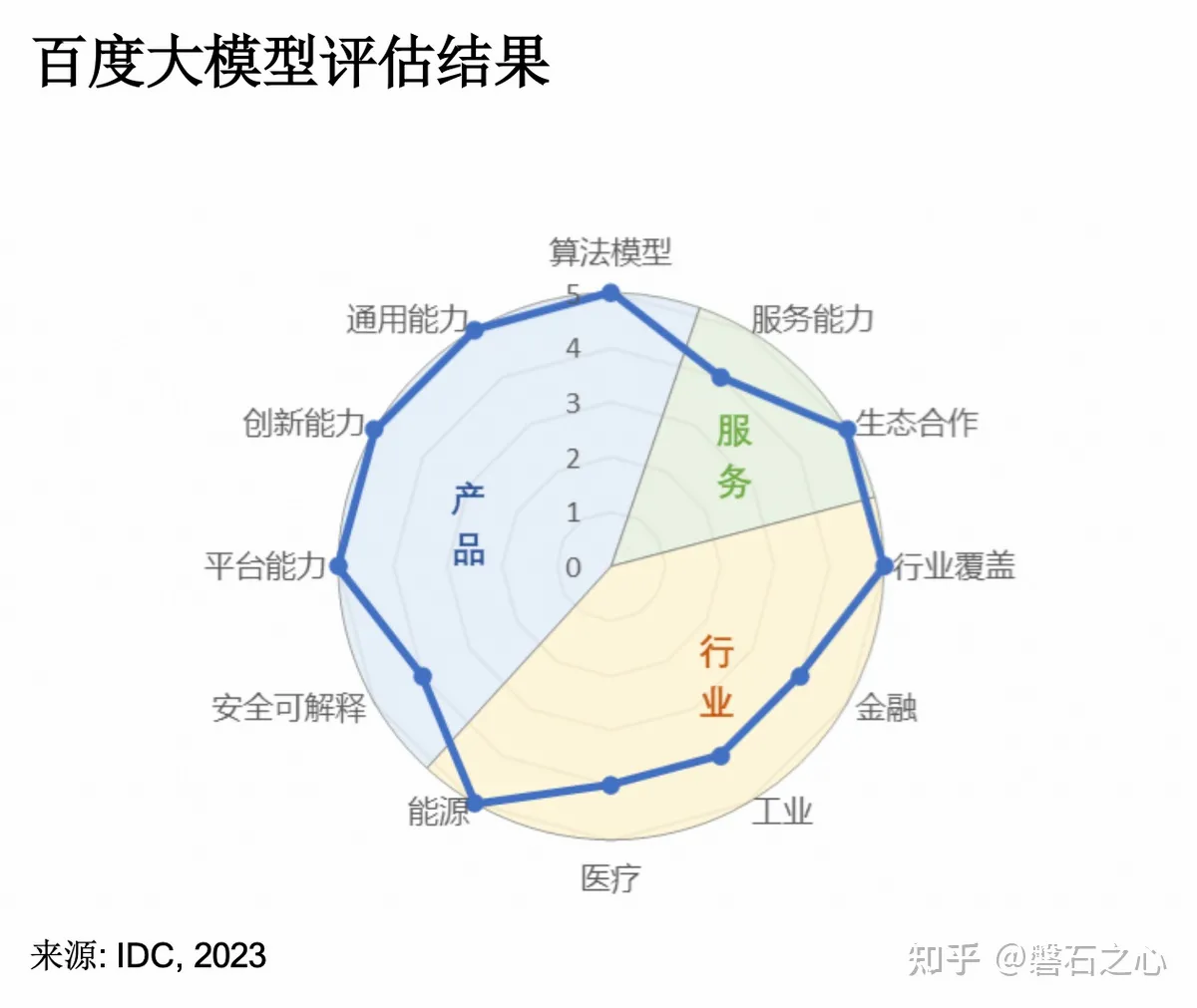

文心模型能力评测总结

文心模型在通用能力测试中表现很好。文案生成,阅读理解,百科问答,代码编写、理解等领域都能取得良好的结果,在学科解题这种专业性知识与逻辑推理能力要求很高的领域还有所欠缺。

文心模型在B、G端垂直领域的应用中也能取得一定的效果。(1)在医疗领域,文心模型能根据患者描述给出合理的病情诊断、治疗药物与治疗手段。(2)在法律领域,文心模型在法律咨询与法律常识科普上表现较好,但是涉及到具体法律条款的引用,会出现模型幻觉的情况,引用的法律条款并不是真实存在。(3)在事件分类中,文心模型在没经过微调但是给出事件类别标签的情况下,能有一半以上的正确率。但是文心偶尔会出现预测的事件类别不在所给出的事件类别集合中,并且当事件类别数量上升时,存在prompt的长度会受限因而不能接受所有事件类别集合的限制。

综上所述,文心模型在通用领域的能力如基本逻辑推理能力,理解能力,创新能力上都有着良好的表现,如图所示官方的测评结果。凭借这些基础能力,其在B、G端也能表现出一定的性能,但是输入长度与模型幻觉的限制,使得在特定领域不能满足具体的需求。因此需要对基座模型进行特定领域的语料扩充与指令微调,并引入外部知识库的方式缓解模型幻觉的问题。

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!